Grand angle

Informations et réflexions pour élargir le débat et connaître le contexte politique et éditorial

3, 2, 1… Déposez vos articles !

Dans un billet précédent, nous expliquions, avec un dessin même, pourquoi le plus souvent il n’y avait aucun obstacle juridique à déposer des articles dans une archive ouverte, y compris ceux déjà publiés…

Depuis la loi pour une république numérique du 8 octobre 2016, c’est encore plus simple : l’article 30 stipule en effet que les articles scientifiques peuvent être diffusés en libre accès par leur auteur, même en présence d’un contrat de cession des droits.

Un cadenas ouvert, symbole de l’open access, qui avance grâce aux nouvelles dispositions législatives

Évidemment, il y a quelques subtilités, sinon ce ne serait pas drôle :

- La rédaction de l’article doit avoir été financé au moins à 50% par des fonds publics français ou européens. C’est le cas, entre autres, lorsqu’un chercheur universitaire ou CNRS écrit dans le cadre de son activité.

- Cette disposition concernerait tous les articles, même ceux publiés avant son entrée en vigueur. Il existe néanmoins un débat sur cette question, notamment en raison du caractère normalement non rétroactif d’une loi et en l’absence de jurisprudence.

- À moins qu’il ne s’agisse d’une publication dans une revue déjà en libre accès, la diffusion par l’auteur ne peut avoir lieu qu’après un certain délai : 6 mois après la publication par l’éditeur dans le domaine des sciences, techniques et médecine – 12 mois dans le domaine des sciences humaines et sociales.

- Seuls les articles publiés dans des périodiques paraissant au moins une fois par an sont concernés. Les participations à des ouvrages collectifs ne le sont donc pas, tout comme les thèses ou les actes de colloques par exemple. Mais rien n’empêche d’arguer de ce principe pour négocier dorénavant dans un contrat d’édition une clause permettant le dépôt en open access…

- L’auteur peut déposer uniquement la version finale du manuscrit acceptée pour publication, après les corrections demandées par les relecteurs, mais avant la mise en forme pour publication par l’éditeur.

- C’est un droit et non une obligation pour les chercheurs, mais ça peut en devenir une dans le cas de projet européen comme H2020.

N’hésitez donc plus à déposer tous vos articles sur Hal-Unice. Si toutefois un doute vous habite, et que vous tenez absolument à être dans la légalité la plus complète, pas besoin de schéma cette fois : les bibliothécaires de Lilliad ont développé WillO, un outil en ligne simple et pratique, pour vous aider à déterminer si vous pouvez déposer vos articles.

Et pour aller plus loin :

- L’article 30 de la loi pour une République Numérique

- Un article très détaillé de Lionel Maurel, spécialiste du droit d’auteur et des bibliothèques, ainsi qu’une de ses interventions

- Le site Couperin de l’accès ouvert en France

Gérer et diffuser les données de la recherche: quels enjeux?

3Les données de la recherche sont précieuses, pour toutes les raisons exposées dans un premier billet. C’est en particulier le cas lorsque leur reproduction est impossible ou difficile (car coûteuse, complexe ou longue) et que leur intérêt potentiel pour la science ou pour la société dépasse le contexte de leur constitution. Il est donc important de les gérer et souhaitable de les partager.

Pourquoi associer la gestion et la diffusion des données?

La gestion des données (data management) désigne au sens large l’ensemble des activités facilitant :

- l’exploitation des données pendant un projet (stockage, partage entre partenaires, sécurisation, description, contrôle qualité…),

- leur préservation à plus ou moins long terme à l’issue du projet,

- leur réutilisation par les partenaires du projet ou éventuellement par des tiers.

La diffusion des données peut se faire quant à elle :

- à la demande (on parlera plutôt de « partage » dans ce cas) ou de bien de manière systématique,

- à destination d’un public large ou restreint,

- et être assortie ou non de conditions ou de restrictions.

Il est en théorie envisageable de bien gérer des données sans pour autant les partager avec des tiers. Par contre, l’inverse n’est pas vrai : pour pouvoir diffuser des données, encore faut-il les avoir au préalable conservées, décrites et documentées. Les financeurs de la recherche, dont l’objectif est de favoriser le partage des données, préconisent donc également l’adoption de bonnes pratiques concernant leur gestion.

Un impératif: préserver, protéger et documenter ses données

Quel que soit l’ampleur du travail, du mémoire de master à la collaboration internationale impliquant des centaines de chercheurs, une perte ou une altération des données peut avoir des conséquences dramatiques pour le projet.

Un accès non autorisé aux données peut également être dangereux pour le projet, mais aussi pour des tierces personnes, en particulier s’il s’agit de données confidentielles ou personnelles. La collecte et le traitement des données personnelles obéit à une réglementation spécifique, appelée à évoluer en 2018, qu’a présentée le correspondant informatique et liberté de l’UNS lors d’une journée d’étude le 23 juin dernier.

Plus généralement, le guide « Pratiquer une recherche intègre et responsable » du comité d’éthique du CNRS (2e édition de décembre 2016) fait de la fiabilité et de la traçabilité des données produites et des traitements réalisés une bonne pratique nécessaire à la fiabilité du travail de recherche. Cela passe en sciences dures par la tenue d’un cahier de laboratoire, qui permet de faciliter le repérage des fraudes, de répondre aux demandes de vérification des relecteurs d’un article, et de sécuriser juridiquement la recherche en fournissant une preuve d’antériorité des résultats.

Partager ses données, quel intérêt pour le chercheur et pour la société?

Au-delà d’une bonne gestion des données, dont l’intérêt est assez évident, quels sont les enjeux spécifiques du partage des données ?

Consolider la science

Une première série d’arguments sont d’ordre scientifique: améliorer la qualité de la recherche, sa visibilité et son impact, et faciliter de nouvelles recherches. Ils sont à replacer dans une logique générale de « science ouverte » : diffusion libre des articles, des données, du code informatique, des algorithmes, des protocoles, transparence de l’évaluation des résultats par les pairs, implication du public dans certaines recherches.

Revenons rapidement sur ces différents points :

Améliorer la qualité et la transparence de la recherche passe par une meilleure reproductibilité des expériences et des analyses. C’est un sujet brûlant en psychologie, en biologie et dans bien d’autres disciplines (voir ce manifeste paru il y a quelques jours dans une revue du groupe Nature). On distingue la « réplication » complète d’une étude, de la collecte des données au résultat final, souvent impossible, et la « reproduction » des résultats à partir des données brutes.

La diffusion des données renforce la visibilité et l’impact d’une étude. Statistiquement, les articles accompagnés de données sont plus cités que les autres (sélection d’articles sur le sujet).

Enfin elle permet de faire avancer plus vite la science :

- Constitution de bases de données internationales de référence, comme en génétique, ou en cristallographie.

- Méta-analyse synthétisant des données issues de plusieurs études pour consolider les connaissances sur un sujet.

- Agrégation ou comparaison de données liées à des lieux ou à des périodes distinctes.

- Application de nouvelles méthodes ou de nouveaux outils à des données anciennes.

- Exploitation de sous-ensembles de données non analysés par leurs producteur (cas de plus en plus fréquent lié à l’augmentation de la taille des jeux de données).

- Nouvelles collaborations avec d’autres chercheurs.

La réutilisation de données est déjà bien établie en génétique ou en astronomie, mais encore balbutiante dans d’autres disciplines. En sciences sociales, elle est par exemple une pratique courante au Royaume-Uni, mais nettement plus marginale en France.

Renforcer la place de la science dans la société

D’autres arguments sont d’ordre socio-économiques, politiques ou patrimoniaux:

- Rationalité économique : la collecte et le traitement des données peuvent couter très cher, il faut donc les « rentabiliser » au maximum, et éviter de recréer des données déjà disponibles.

- Bon usage de l’argent public : la recherche financée sur fonds publics devrait bénéficier à tous, et donc être diffusée sans barrière et le plus largement possible.

- Utilité pour la société et les entreprises : cela concerne au premier chef les données d’essais cliniques, épidémiologiques, économiques, climatologiques, environnementales, etc. A titre d’exemple, la communauté scientifique américaine est fortement mobilisée depuis plusieurs mois pour préserver les données climatologiques, de peur que le président Trump ne les fasse disparaître ou ne restreigne leur disponibilité.

- Maîtrise des données par la communauté scientifique : même si des acteurs privés (éditeurs, sociétés spécialisées) ont un rôle à jouer dans la diffusion des données, la communauté scientifique doit pouvoir en conserver la maîtrise.

- Constitution d’un patrimoine scientifique. On peut aujourd’hui accéder aux oeuvres et aux travaux préparatoires de Darwin, Newton ou Claude Bernard. Mais de quels éléments disposeront nos héritiers pour documenter l’histoire de la science du XXIe siècle?

- Respect des obligations et recommandations des universités, financeurs et revues. Ces politiques, variables selon les pays et les disciplines, ont été mises en place depuis une dizaine d’années pour apporter une réponse institutionnelle à tous les enjeux exposés précédemment.

Des freins et des difficultés à prendre au sérieux

Le partage et la réutilisation des données de la recherche sont encore loin d’être généralisés. Cela s’explique par différentes objections, qui sont de différents ordres.

Les objections pratiques sont multiples :

- Manque de temps.

- Coût lié à la préservation des données.

- Manque de compétences.

- Manque d’infrastructures adaptés.

L’organisation traditionnelle de la recherche et de la communication scientifique ne favorise pas le partage :

- Faible incitation institutionnelle.

- La communication des résultats scientifique passe avant tout par la rédaction d’articles.

- Manque de reconnaissance du partage de données dans le processus d’évaluation des chercheurs.

Un partage trop rapide et non préparé peut avoir des effets négatifs :

- Risque de mauvaise interprétation des données, qui pourrait nuire à leur producteur.

- Risque d’une mise en évidence d’erreurs dans la collecte ou le traitement des données.

- Risque de favoriser le travail d’une autre équipe au détriment de la sienne, dans un contexte de concurrence de plus en plus vive entre chercheurs. C’est particulièrement vrai lorsqu’un même jeu de données peut donner lieu à plusieurs publications étalées sur plusieurs années.

Les réticences les plus profondes sont liées à la nature même des processus de recherche :

- Difficultés théoriques ou méthodologiques pour réutiliser des données dans certaines disciplines: comme l’explique le projet ANR Reanalyse, « la démarche qualitative construit des données (observations, entretiens en particulier) qui sont produites dans l’interaction du chercheur avec le milieu qu’il étudie : leur réutilisation dans un autre contexte ne va donc pas de soi ».

- Pratiques parfois trop hétérogènes pour que les données puissent facilement être réutilisées : manque d’un format commun partagé par tous les chercheurs une discipline, etc.

Enfin des questions juridiques et éthiques sont à prendre en considération :

- Utilisation de données personnelles ou sensibles, en particulier dans le domaine médical.

- Utilisation de données détenues par un tiers.

- En sciences sociales, la recherche « procède le plus souvent sur la base d’un contrat de confiance entre l’enquêté et l’enquêteur qui n’inclut pas la mise à disposition des informations fournies à d’autres que ceux à qui elles ont été confiées » (citation du projet Reanalyse)

Comment répondre à ces enjeux tout en tenant compte de ces freins? Vous le saurez dans le prochain épisode!

En attendant, quelques liens pour aller plus loin si le sujet vous intéresse :

Pour s’informer

- Site national de veille et information sur les données de la recherche (MENESR, CNRS, INIST-CNRS, INSERM, INRA, IRD)

- Guide d’introduction aux données de la recherche destiné aux doctorants de Bretagne et Pays de Loire (site Formadoct)

- Services et ressources de l’INRA (peut être utile à des chercheurs non rattachés à l’INRA)

- Dossier du CIRAD (idem)

- Série d’articles sur le site des correspondants information scientifique et technique de l’Institut des SHS du CNRS

- Bon article de vulgarisation dans le journal du CNRS : « Préserver les données de la recherche à l’ère du Big Data« , 09/09/2016, par Guillaume Garvanèse

- Billet de l’URFIST de Paris : « Données » de la recherche, les mal-nommées, 15/11/2013 par Sylvie Fayet

Pour se former

- Projet Doranum de formation à distance sur la gestion et le partage des données (INIST-CNRS et réseau des URFIST, avec la participation de la BU de Nice)

- Services et tutoriels sur les données de la recherche sur produits par l’INIST-CNRS

Les données, quel enjeu pour la recherche et les bibliothèques?

5Un nombre croissant de revues scientifiques demandent aux auteurs de rendre disponibles les données analysées dans leurs articles. C’est par exemple le cas du prestigieux groupe Nature. Ce mouvement international, né dans des disciplines productrices et réutilisatrices de grandes quantité de données (astrophysique, physique des hautes énergies, génomique…), s’étend peu à peu à d’autres domaines, comme les essais cliniques, et se généralise sous l’impulsion d’universités, d’agences de financement de la recherche, de gouvernements et d’organisations scientifiques internationales.

Comment expliquer cette évolution, et comment l’accompagner?

Qu’entend-on par données de la recherche?

La notion de données fait partie de l’ »outillage intellectuel » standard des sciences de la matière et du vivant, et de certaines sciences sociales. Mais un informaticien, un statisticien, un sociologue ou un physicien se font-ils la même idée de leurs « données »? Plusieurs définitions des « données de la recherche » ont été proposées depuis une dizaine d’années, mais elles ont été formulées par différents organismes dans un but opérationnel, et non à l’issue d’une réflexion philosophique. Une des plus influente a été proposée en 2007 dans les Principes et lignes directrices de l’OCDE pour l’accès aux données de la recherche financée sur fonds publics :

les «données de la recherche » sont définies comme des enregistrements factuels (chiffres, textes, images, sons) utilisés comme source principales pour la recherche scientifique et généralement reconnus par la communauté scientifique comme nécessaires pour valider les résultats de la recherche. Un ensemble de données de recherche constitue une représentation systématique et partielle du sujet faisant l’objet de la recherche »

Notons que cette définition fortement marquée par les sciences dures devrait être adaptée pour s’appliquer pleinement aux sciences humaines et sociales.

Les données se présentent aujourd’hui le plus souvent sous forme numérique, mais ce n’est pas une obligation, et le retraitement de données anciennes impose bien souvent la manipulation de documents physiques.

Elles sont très diverses en terme de format, de volumétrie, et de méthode de constitution ou de collecte.

Toutes ne sont pas créées dans le cadre d’un projet spécifique, car elles peuvent également avoir pour origine :

- l’observation régulière de la nature (séismes, climat…) ou de la société (recensements, statistique publique…),

- l’activité d’organismes publics, d’entreprises et d’individus,

- un autre projet de recherche, éventuellement mené par une équipe différente.

On distingue fréquemment plusieurs « niveaux » de données, par exemple :

- brutes, sans trace de subjectivité (issues directement d’un instrument, etc.),

- traitées (filtrées, corrigées, calibrées, normalisées, etc.),

- dérivées (agrégation, vue spécifique ou synthétique des données, représentation graphique),

- analysées et interprétées (par le texte d’une publication scientifique).

Un enjeu scientifique majeur

Historiquement, les données exploitées par les chercheurs pouvaient être issues :

- d’expériences en environnement contrôlé,

- de l’observation de la nature

- de l’observation de l’homme en société

Cependant l’essor de l’informatique et de l’instrumentation a permis progressivement (depuis quelques décennies ou quelques années selon les disciplines) :

- la création de données « in silico » au moyen de simulations et de modélisations,

- la production d’une quantité toujours croissante de données par divers équipement scientifiques,

- la production de données dans tous les secteurs de la société (industrie, santé, communication, marketing…), qui peuvent devenir autant de sujets d’étude,

- de nouvelles formes de collaborations scientifiques impliquant le partage ou l’élaboration collective de données à large échelle (initiatives internationales en astronomie, génomique, neurosciences, etc.),

- le développement de nouvelles techniques d’analyse, de nouveaux questionnements, voire de nouveaux paradigmes scientifiques dans les disciplines traditionnellement utilisatrices de données mais aussi dans les sciences humaines (« humanités numériques »),

- un diffusion et une réutilisation plus aisée et moins coûteuse des données.

Mais les enjeux liés aux données de la recherche sont aussi économiques et sociétaux, car les données sont devenues stratégiques pour nombre d’entreprises, les pouvoirs publics, et la société dans son ensemble. Cela rend possibles de nouvelles formes de partenariats centrés sur les données entre le monde de la recherche et la société :

- réutilisation de données publiques ou privées par la recherche publique,

- réutilisation de données produites par la recherche par des acteurs publics ou privés,

- partenariats public/privé.

Pourquoi vous parler de tout cela?

Une des missions des bibliothèques universitaires consiste à soutenir la recherche, ce qui implique de :

- Donner accès à des informations scientifiques et techniques, traditionnellement présentées sous forme de livres, de revues ou de bases de données spécialisées,

- Valoriser la production de leur établissement, en promouvant notamment sa diffusion en open access.

Or les données scientifiques tendent à devenir un objet communicable et valorisable au même titre qu’une publication. Les bibliothèques des grandes universités de recherche étrangères ont donc investi ce nouveau champ, en travaillant conjointement avec les services informatique, l’administration de la recherche, et les chercheurs eux-mêmes (voir par exemple à Edinburgh ou dans le Wisconsin). Les universités françaises sont moins avancées, mais plusieurs BU ont des projets de cette nature, et des services ont été développés par l’INIST-CNRS et l’INRA.

Voici pourquoi nous menons depuis l’an dernier une réflexion sur ce sujet, que nous partagerons avec vous sur HTTBU. Après ce premier billet introductif, nous aborderons :

- les principaux enjeux liés au partage et à la gestion des données,

- des questions plus pratiques comme la mise en place de plans de gestion de données,

- les exigences de l’Union européenne dans le cadre du programme Horizon 2020,

- les ressources de formation et d’autoformation.

Si vous souhaitez en savoir plus, ou si vous avez des questions sur un point particulier, vous pouvez nous contacter en écrivant à donnees-scd@unice.fr.

Retour d’expérience: aide à la constitution d’un corpus bibliographique sur les études africaines

3Entre l’été 2014 et l’automne 2015, la BU a collaboré avec un groupe de chercheurs réalisant un livre blanc sur les études africaines. Nous reviendrons dans ce (long) billet sur la nature et le cadre de cette intervention, et les enseignements que nous en avons tiré.

[Billet mis à jour le 9/12/2016 : ajout de l’étape d’harmonisation des disciplines des thèses avec l’outil Openrefine]

Un livre blanc sur les études africaines en France

Différents laboratoires de sciences humaines et sociales français consacrent tout ou partie de leurs travaux à des aires culturelles spécifiques. Sous l’égide de l’institut des SHS du CNRS, quatre GIS (groupements d’intérêt scientifique) fédèrent les compétences et encouragent les partenariats entre spécialistes de l’Afrique, de l’Asie et du Pacifique, des Amériques, et du Moyen orient et du monde musulman. Le GIS sur les études africaines en France regroupe 33 laboratoires, dont l’Unité de Recherche Migrations et Société (URMIS), spécialisée dans l’étude des migrations et des relations interethniques, qui dépend à la fois des université de Nice et Paris-Diderot, de l’Institut de recherche et du développement, et du CNRS.

À la demande du CNRS, ces quatre GIS ont produit des « livres blancs » faisant le bilan des études dans leurs domaines respectifs. Une synthèse de ces livres blanc a été réalisée et une journée d’étude organisée à Paris le 24 octobre dernier. Les livres blancs sont accessibles librement et constituent des documents fort utiles pour faire le point sur les équipes de recherche, les moyens humains et les centres de documentation spécialisés concernant le Moyen-Orient et les mondes musulmans, les Amériques, l’Asie et le Pacifique, et l’Afrique.

À l’été 2014, Mmes Streiff-Fénart, Ballarin et Lesclingand, chercheuses de l’URMIS impliquées dans la rédaction du livre blanc sur les études africaines, ont pris contact avec les collègues de la BU Saint Jean d’Angély, qui avaient déjà noué des relations de longue date avec leur laboratoire. Elles souhaitaient collecter des informations sur les thèses et les articles concernant l’Afrique. Leur demande a été essentiellement étudiée par le département d’ingénierie documentaire des BU, qui leur a proposé d’extraire et d’enrichir semi-automatiquement des données bibliographiques à partir de différentes sources.

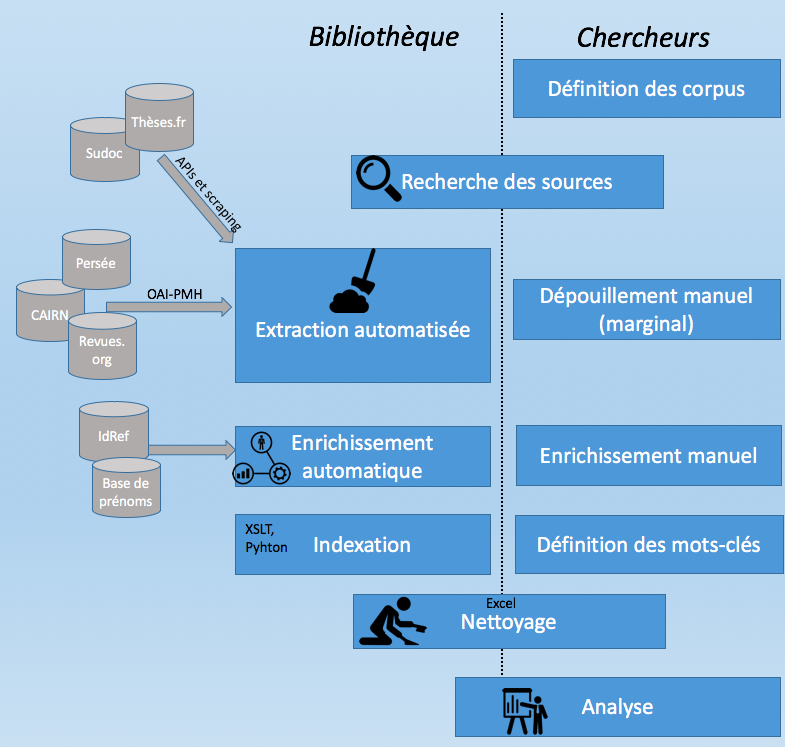

L’intervention de la bibliothèque

Nous avons fourni trois jeux de données, concernant

- Les thèses en SHS concernant l’Afrique, soutenues en France de 1930 à 2014 (15 546) ;

- Les articles concernant l’Afrique dans une sélection de 7 revues spécialisées sur l’Afrique, de 1960 à 2013 (3 919) ;

- Les articles concernant l’Afrique dans une sélection de 40 revues de SHS, de 1960 à 2013 (4 941).

Les informations fournies étaient des « métadonnées » (auteur, titre, revue, date, résumé, sujet), et non le texte intégral des articles.

Ce travail a mobilisé les compétences de plusieurs collègues chargés de la documentation électronique et de l’ingénierie documentaire (pour les sources numériques et les aspects techniques), ou en poste dans les BU Saint-Jean d’Angély et Droit (pour les sources imprimées). Il a nécessité une collaboration régulière avec les chercheuses (6 réunions et de nombreux échanges) afin de préciser leurs besoins (liste des revues, critères d’inclusion ou d’exclusion des articles et des thèses, mots clés thématiques et géographiques) et la répartition du travail. Enfin il s’est avéré très prenant tant pour nous que pour les chercheuses, notamment dans la phases de nettoyage des données.

Plusieurs sources ont été utilisées:

- Pour les thèses : le portail thèses.fr et le Sudoc (pour les thèses soutenues avant 1985, absentes de thèses.fr) ;

- Pour les revues : les sites Persée, Revues.org et CAIRN, quelques sites de revues isolés.

Notons que certaines revues ont dû être dépouillées manuellement par une stagiaire encadrée par le laboratoire.

La récupération d’information a mobilisé plusieurs techniques:

- Protocole OAI-PMH ;

- API de theses.fr ;

- Web scraping (Sudoc et sites de revues isolées).

Ces données ont été agrégées et dédoublonnées, enrichies et indexées:

- Détermination des disciplines des thèses (les informations étant présentées de manière très hétérogènes dans nos données, nous avons utilisé l’outil OpenRefine pour les harmoniser)

- Ajout du sexe des auteurs (extrait de la base IdREF, ou bien obtenu par croisement avec une liste de prénom) ;

- Indexation thématique et géographique à partir de mots clés présents dans les titres et les résumés. L’indexation géographique a pris en compte les ethnies, les pays, les macro-régions (Afrique de l’Ouest, Sahara…), et certaines formes « alternatives » (variantes de noms de pays, gentilés, capitales et villes principales…).

Puis nettoyées et filtrées (en grande partie manuellement…):

- Suppression de certains types de documents (éditoriaux, nécrologie, notes de lecture) ;

- Suppression d’articles en anglais ;

- Suppression d’articles et de thèses non liés aux sciences humaines (géologie, climatologie, etc.).

Différents outils ont été mobilisés:

Lors des premières étapes, la chaîne d’enrichissement des données a reposé essentiellement sur des traitements en XSLT. Ultérieurement, de petits scripts en Python ont également utilisés. Mais c’est Excel qui a servi d’outil de base pour la compilation, le contrôle qualité et le nettoyage des données. Nous avons également eu recours au logiciel Tableau pour visualiser des données dans une phase intermédiaire du projet.

L’analyse des données

Les données fournies par la BU ont fait l’objet d’une première analyse rapide afin de contrôler la qualité des données, puis d’une analyse plus approfondie par les membres du GIS, présentée dans la 3e partie (« L’Afrique dans les thèses et les revues ») du livre blanc.

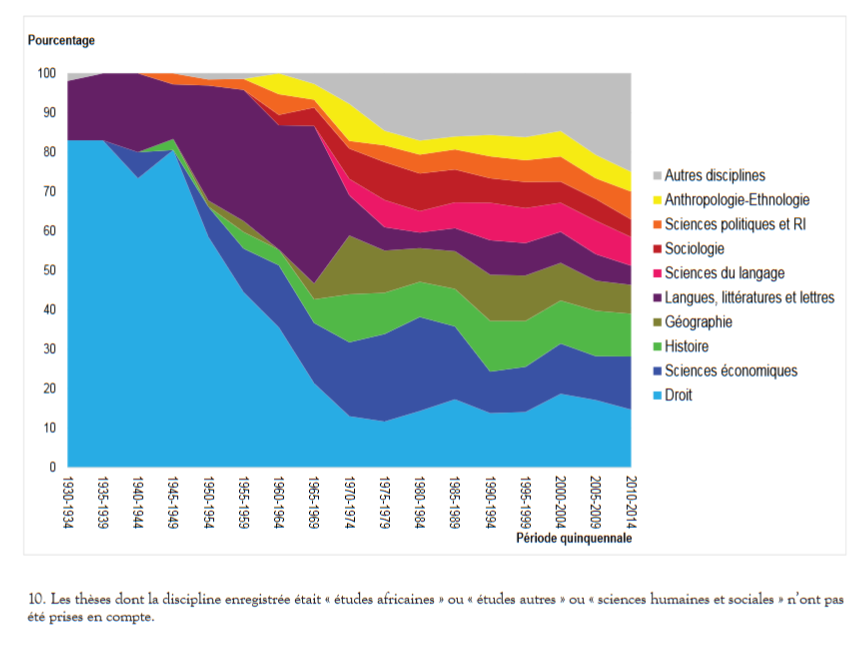

Concernant les thèses, les auteurs ont pu mettre en évidence:

- Une forte progression du nombre de thèses à la fin des années 1970 et dans les années 1980, puis une stabilisation (environ 400 thèses par an sur l’Afrique aujourd’hui) ;

- Une domination du droit et des langues jusqu’aux années 1970, puis une diversification (histoire, géographie, sciences économiques, sciences politiques, anthropologie) ;

- Une suprématie francilienne et parisienne : Près de la moitié des thèses sur l’Afrique ont été soutenues dans une université francilienne, principalement dans Paris intra-muros. Bordeaux et Aix-Marseille constituent deux pôles secondaires importants ;

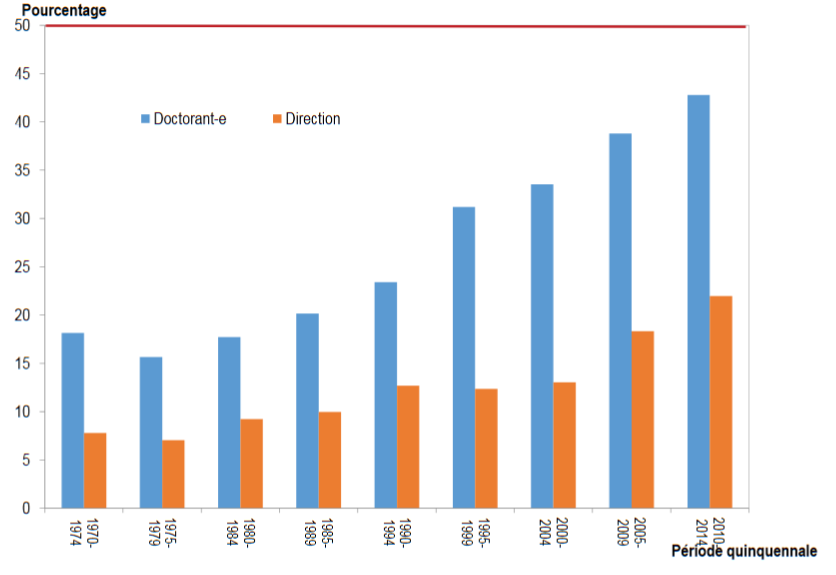

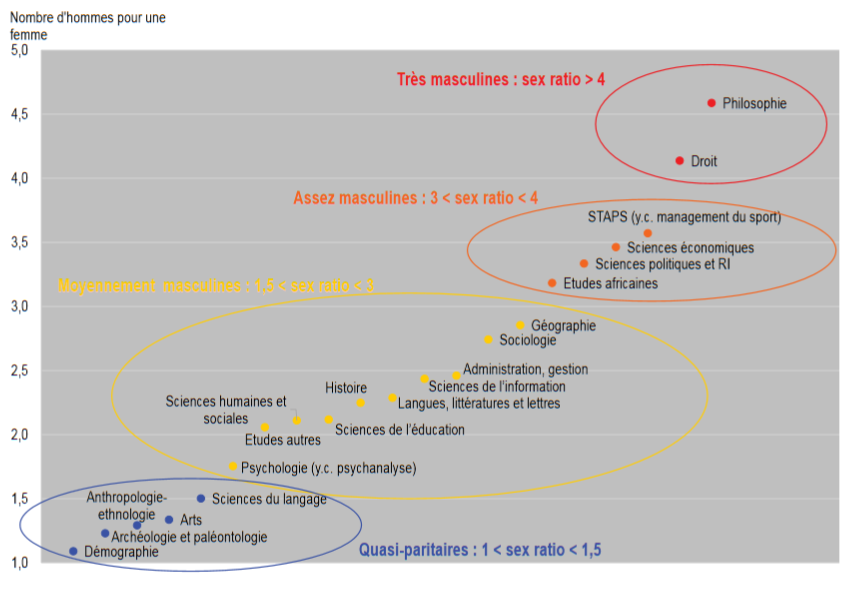

- Un sex-ratio très déséquilibré en défaveur des femmes, le différentiel tendant à s’atténuer dans la période la plus récente, mais beaucoup plus lentement pour les directeurs de thèses que pour les doctorants ;

- Un sex-ratio très différentié selon les disciplines : 1 doctorante pour 4 ou 4,5 doctorant en droit ou en philosophie (mais la philosophie ne représente que 0,7% des thèse, le sex-ratio est à prendre avec précaution), contre 1 pour 1 en démographie, et 1 directrice de thèse pour 11 à 12 directeurs en sciences économiques et politiques !

D’autres analyses ont porté sur les revues:

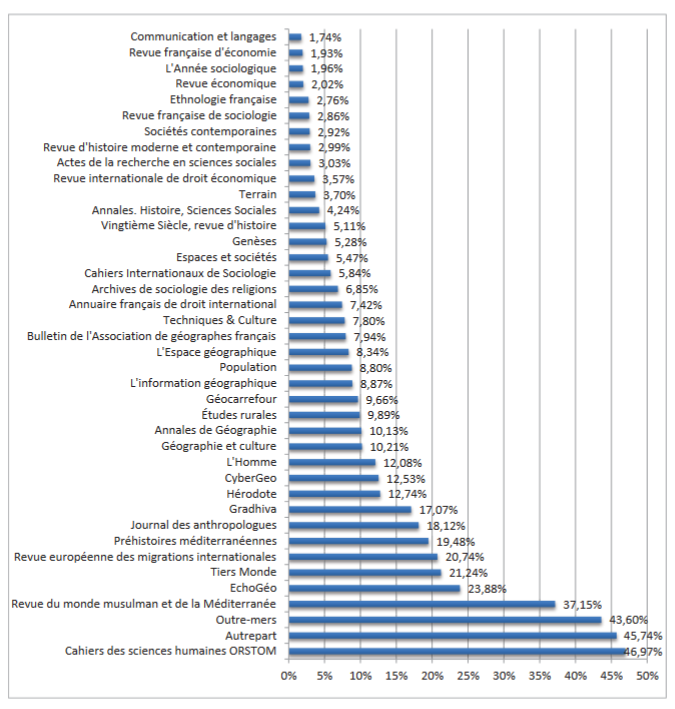

- La part des articles consacrés à l’Afrique dans des revues non spécialisées : L’Afrique est bien représentée (19 à 48 % des articles) dans les revues thématiques sur le développement, le Sud, les grandes aires culturelles, les migrations, et dans une moindre part (8 à 23%) dans les revues géographie, d’anthropologie et de démographie. Elle occupe une place réduite dans les revues d’histoire, de droit, d’économie et de sociologie.

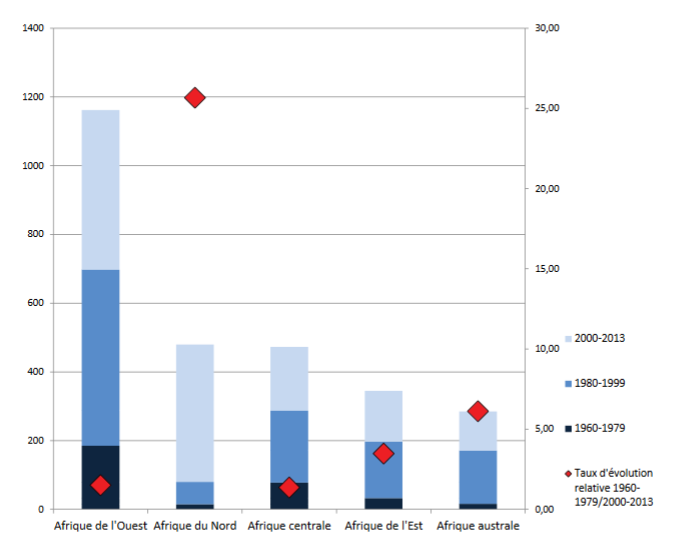

- L’importance respectives des différentes macro-régions dans les revues spécialisées sur l’Afrique: les articles concernant l’Afrique de l’Ouest (en particulier la Côte d’Ivoire, le Sénégal et le Mali) sont de loin les plus nombreux, mais le nombre d’articles consacrés à l’Afrique australe et l’Afrique de l’Est a fortement progressé au cours de la période (ainsi que ceux consacrés à l’Afrique du Nord, mais il s’agit en partie d’un artéfact statistique du à la prise en compte de la revue Maghreb-Machrek à partir de 2003)

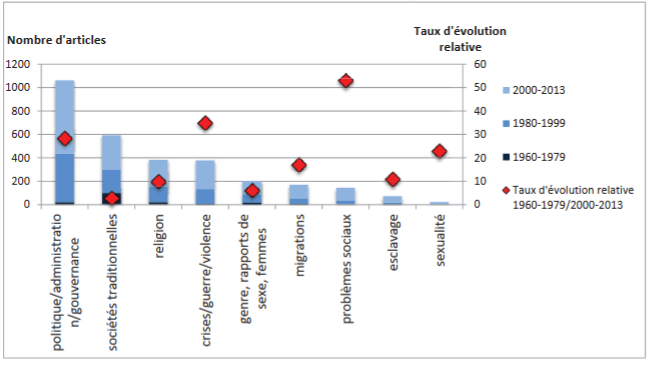

- Poids et évolution des différents thèmes dans les revues spécialisées: et surtout leur évolution: dans les années 1960, les articles évoquaient en priorité des sujets liés aux sociétés traditionnelles. Dans les années 2010, cette place est occupée par les sujets liés à la politique et à l’administration. Des thèmes quasiment inexistant il y a 50 ans ont désormais une place importante: la communication, le droit, la sexualité, les problèmes sociaux, les crises, la guerre et la violence.

Précautions d’usage

Notre travail, en tant que « producteurs » des données a aussi été d’avertir les chercheuses de la présence de divers biais, dont certains n’ont pas pu être corrigés :

- « Silence documentaire » (documents non intégrés au corpus) lié à des sources lacunaires (certaines revues n’étaient pas en ligne pour des périodes clés, et n’ont pas pu être dépouillées manuellement) et au non-repérage d’articles si les mots clés liés à l’Afrique n’étaient pas présents dans le titre ou le résumé ;

- « Bruit documentaire » (documents intégrés à tort au corpus) lié à la présence de mots clés liés à l’Afrique dans des titres ou résumés d’articles pourtant non liés à l’Afrique, de mots clés ambigus, et à la difficulté d’exclure certains types de documents (nécrologies, éditoriaux, notes de lecture…) ;

- Silence et bruit dans l’indexation des documents intégrés au corpus ;

- Hétérogénéité quantitative et qualitative du corpus: création et disparition de revues, métadonnées de plus en plus précises et détaillées au fil du temps (le taux de résumés disponibles croit fortement à partir des années 1980, ce qui induit mécaniquement un accroissement du nombre de mots clés reconnus) ;

- Importance du nettoyage manuel, et donc possibilité d’erreurs humaines.

Quel bilan?

Concernant la communication avec les chercheuses, notre position d’« extériorité » a pu être un handicap, qui a entraîné quelques malentendus, et un surcroît de travail pour toutes les parties prenantes. Nous avons pu également constater des différences « culturelles » entre bibliothécaires et chercheurs (par exemple, un bibliothécaire fera tout pour conserver les identifiants permettant de recroiser des données, alors qu’une démographe aura le réflexe de les supprimer).

L’idée initiale d’une « extraction automatisée de données » a dû être fortement nuancée, surtout sur un corpus aussi hétérogène. Certaines sources ont dû être dépouillées manuellement, d’autres n’ont pas pu l’être, et les données finalement recueillies ont été plus hétérogènes que prévu, ce qui a entraîné un travail important de nettoyage de notre part et de la part du GIS, et a limité la faisabilité ou la fiabilité de certaines analyses.

Nous avions pensé utiliser certaines sources qui n’ont finalement pas pu être retenues pour des raisons techniques, de qualité et de complétude des données (les premiers essais à partir des données d’Isidore n’ont pas été concluants) ou de disponibilité (un export global des thèses du Sudoc nous aurait fait gagner du temps).

Les méthodes mises en œuvre liaient fortement les phases d’extraction et d’indexation. Ces deux volets gagneraient à être distingués : même si l’extraction est basée sur certains mots-clés, ce ne sont pas forcément ces mots-clés qui doivent servir lors de l’analyse.

Enfin, les outils et méthodes développés n’ont pas été pensées dès le départ pour être réutilisables. Si un projet du même type se représentait, nous chercherions à les rendre plus génériques.

Et après?

La contribution au livre blanc sur les études africaines nous a permis de confirmer notre intuition de départ: les bibliothèques disposent de compétences qui peuvent être utiles à certains projets de recherche.

D’autres expérimentations du même type sont en cours, et seront le sujet de billets à venir.

QOA ? Des recettes de cuisines ?

0Les BU de Nice aiment la cuisine ! Après avoir servi la Petite cuisine de la documentation électronique en 3 plats, nous proposons aujourd’hui la recette du dépôt d’article sur son lit d’archives ouvertes, et sa sauce Creative commons, accompagnés de vraies bonnes recettes à télécharger, et à faire mijoter en même temps que vous déposez votre article… Mais pourquoi des recettes de cuisine sur un blog dédié aux publications scientifiques électroniques ?

Pour attirer les gourmands et leur expliquer comment déposer un article dans Hal, mais aussi pour éclairer sur la différence entre ce qui est LIBRE et ce qui est GRATUIT… valable aussi bien dans le domaine universitaire que dans le quotidien. On entend en effet très souvent « Moi je préfère ResearchGate à Hal… », « Je préfère Googledocs à Framapad… », « Je préfère Photofiltre à Gimp… », « Je préfère Internet Explorer à Firefox… », « Je préfère Facebook à Diaspora*… », « Je préfère Marmiton à Cuisinelibre... », avec toujours la même chute « C’est pareil, c’est gratuit ! »

On a le droit de préférer ce qu’on veut, mais en connaissance de cause, car non ce n’est pas pareil : ResearchGate, Googledocs, Photophiltre, Internet explorer, Facebook, Marmiton sont peut-être gratuits, mais pas libres. Ils imposent à tous ceux qui les utilisent et les alimentent des restrictions et des obligations, et privatisent les données. Ce qui n’est pas le cas de Hal, Framapad, Gimp, Firefox, Diaspora* et Cuisine libre, qui eux sont libres. Chaque outil mériterait un comparatif et un développement détaillé du point de vue juridique, philosophique, économique, technologique ou social, mais pour commencer simplement, petite explication en cuisine :

Il existe des sites de cuisines « collaboratifs », où sont disponibles gratuitement des recettes, déposées par les internautes. Gratuitement, mais pas librement ! En effet, ces sites imposent des conditions restrictives à ceux qui y publient et qui les consultent. C’est le cas par exemple de Marmiton. Les conditions d’utilisation des recettes sont strictement encadrées : on peut « utiliser toutes les recettes diffusées sur le site pour [un] usage privé : repas entre amis ou en famille » uniquement. Les professionnels ont un droit limité, ils sont obligés de mettre un commentaire sur le site et de l’indiquer sur leur menu. Les écoles de cuisines n’ont pas le droit d’utiliser les recettes. Et enfin les recettes deviennent la propriété du site. Sans remettre en cause le fonctionnement et les objectifs commerciaux légitimes de Marmiton, on constate qu’il y a une privatisation d’un savoir fourni par une communauté dont la première (seule ?) motivation est de partager leur goût pour la « bonne bouffe »… En d’autres mots, les recettes, les commentaires, toutes informations n’appartiennent plus à ceux qui les ont déposés, mais à l’entreprise, qui a déjà sorti un magazine imprimé payant, mais qui pourrait aussi par exemple décider de bloquer un jour l’accès à toutes les recettes pour uniquement les commercialiser.

Il existe un site de cuisine libre, qui respecte le philosophie de partage et de diffusion du savoir (culinaire), Cuisinelibre.com. La licence Creative Commons CC BY SA appliquée aux recettes autorise leur réutilisation quel que soit l’environnement et le statut, amateur, professionnel, enseignant, avec comme seule limite celle de la licence. Il s’agit de citer l’origine de la recette et d’appliquer la même licence. On peut même les vendre si on veut, l’essentiel étant que ça ne limite pas la liberté des autres cuisiniers potentiels. C’est ce qui nous a permis de les reproduire, de les modifier, de les distribuer pendant l’Open Access Week, et de les diffuser sur ce blog.

Et le même raisonnement s’applique à tous les outils, réseaux et sites cités au début de ce billet. Même si ici la démonstration a ses limites : de toute façon, juridiquement les recettes de cuisines ne sont pas protégées en France par le droit d’auteur, vous pouvez donc faire ce que vous voulez de toutes les recettes trouvées sur le web… Mais on avait besoin de justifier pourquoi on travaillait sur la tarte à la bière et la tartiflette 🙂

Bon appétit et bon dépôt !

Les recettes sont là !

Nouvelles formes de communication et d’évaluation scientifique (2/2)

1Vous vouliez en savoir plus sur la journée nationale des URFIST du 25 septembre ? Voici la suite !

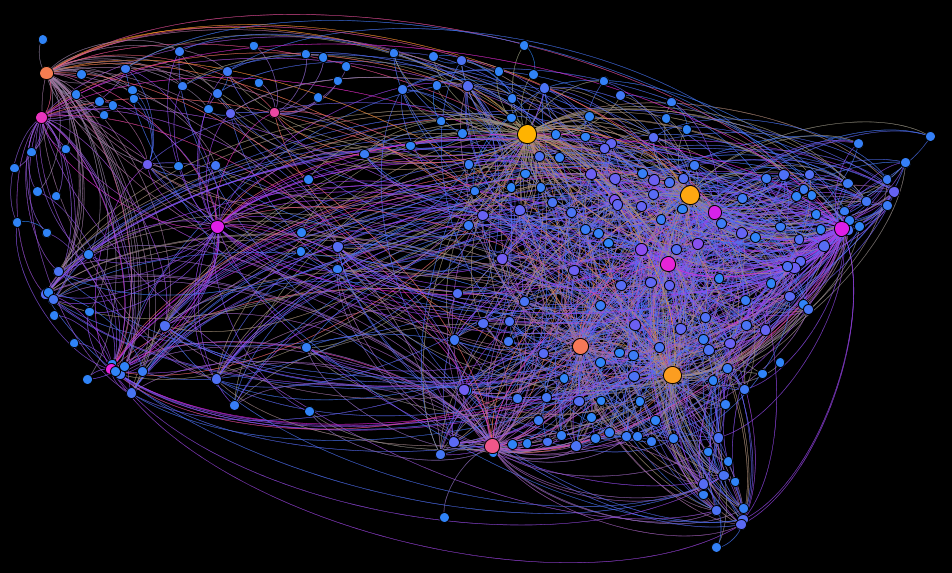

La présentation par Rodrigo Costas -Comesaña de ses travaux sur Altmetrics a permis de faire un point sur la définition des altmetrics, les outils concernés (plateformes sociales comme Mendeley, ResearchGate, outils grand public comme Twitter, Facebook), les données disponibles, les biais, et ce que l’on peut en attendre.

Le travail sur ces données présente de nombreux problèmes (corrélation entre les sources ou manque de cohérence au sein du même outil, difficulté de manipulation, manque de normalisation…). On note dans les résultats une sous-représentation de certaines disciplines plus complexes, ou si les titres d’article sont trop longs (twitter et facebook). L’intérêt semble donc plus de mesurer la réception et la vision sociale de la science par le profane que d’en tirer une évaluation des travaux.

Le sociologue des sciences Yves Gingras a remis en perspective historique ces évolutions. La situation actuelle résulte à la fois de l’arrivée d’Internet, qui a changé l’unité (de la revue à l’article), de la financiarisation de l’économie de l’édition, et de l’avènement d’un nouveau management public au sein des universités (centré sur l’évaluation). L’utilisation des indicateurs pour l’évaluation dépend de la fonction de l’institution. Il faut s’interroger sur les outils disponibles et leurs limites pour l’objectif visé (l’indice H est mal conçu ; Scopus et Wos, quoique incomplets, restent mieux contrôlés, que d’autres).

Les données de la recherche sont un autre sujet d’actualité. Le directeur exécutif de Codata (Committee on Data for Science and Technology- ICSU) a présenté les initiatives en cours pour promouvoir l’ouverture des données de la recherche : groupes de travail, déclaration Open access, avec des recommandations pour la citation normalisée des ensembles de données, projet d’attribution de DOI aux données (Datacite), entrepôt international de dépôt (Dryad).

Au total, une journée riche et instructive.

Retrouvez dans les abonnements électroniques de l’UNS les publications de Rodrigo Costas (Springer, Wiley) et celles d’Yves Gingras (Cairn.info, Erudit)

Voir aussi la première partie du compte-rendusur ce blog, et les interventions en vidéo sur le wiki de l’URFIST de Nice

Nouvelles formes de communication et d’évaluation scientifique (1/2)

2 Le 25 septembre l’UNS a accueilli la journée des URFIST, consacrée aux nouvelles formes de communication et d’évaluation scientifique (voir le programme en ligne). L’occasion de mettre en perspective les pratiques d’édition et d’évaluation actuelles dans l’environnement numérique, et de faire le point sur des termes souvent cités, mais au contenu encore flou (épi-revues, Altmetrics).

Le 25 septembre l’UNS a accueilli la journée des URFIST, consacrée aux nouvelles formes de communication et d’évaluation scientifique (voir le programme en ligne). L’occasion de mettre en perspective les pratiques d’édition et d’évaluation actuelles dans l’environnement numérique, et de faire le point sur des termes souvent cités, mais au contenu encore flou (épi-revues, Altmetrics).

La première intervention était consacrée aux épi-revues. Alain Monteil a présenté la stratégie de l’INRIA. L’institut a fait le choix volontariste de la voie verte de l’Open Access : dépôt obligatoire sur Hal pour les chercheurs, et évaluation basée sur les listes de publication Hal. Une offre Open Access est élaborée, en partenariat avec le CCSD, autour du dépôt dans Hal-INRIA, de Sciencesconf.org pour les conférences, et de la plateforme Episciences (revues). Le Journal of Data Mining & Digital Humanities (trimestriel) est déjà en ligne. D’autres projets concernent IAM- Informatics & applied mathematics,DMTCS- Discrete Maths & Theoretical Computer Science.

Ces épi-revues veulent offrir un nouveau modèle de publication, notamment dans des sciences mal représentées dans l’édition traditionnelle. Elles fournissent un label de qualité en continuité avec les éditeurs classiques (comité éditorial, évaluation par les pairs, archivage à long terme, visibilité et référencement) mais cherchent également à dépasser leurs limites : fournir un accès libre sans embargo dès la soumission de l’article, favoriser les échanges entre scientifiques en intégrant la dimension des réseaux sociaux ; réunir plusieurs objets (images, codes, vidéos…) ; aller vers la transdisciplinarité.

Le rôle de l’édition a été interrogé par plusieurs intervenants.

Pierre Mounier (Cleo) a évoqué les pratiques des blogs et carnets de recherche en SHS. Parfois présentés comme un moyen pour les chercheurs de retrouver une liberté d’écriture, en opposition aux publications, ces carnets recouvrent de fait des réalités plus variées, en hybridation avec l’édition traditionnelle qui conserve son rôle : blogs de chercheurs, veille, communication plus ou moins institutionnelle autour de projets de recherche, accompagnement éditorial (informations, discussions, commentaires). On peut citer en exemple les carnets des revues VertigO ou Terrain. La publication peut d’ailleurs à son tour naître à partir de billets de blogs (collection de livres Open edition press).

David Monniaux a tracé une vision très différente de l’édition en informatique, où le travail de mise en forme est perçu comme à la charge de l’auteur. Son blog n’aborde pas son travail de recherche, pas assez grand public. Il induit un mode d’écriture et des précautions spécifiques.

Les entreprises aussi s’interrogent sur les modèles éditoriaux. Faculty of 1000 a présenté deux de ses produits : F1000Prime (sélection d’articles par des scientifiques) ; F1000Research (publication en libre-accès sur le modèle auteur-payeur).

De façon comparable aux épi-revues, il y a une volonté de mise à disposition de l’article dès l’origine et de visibilité sur le processus d’évaluation (commentaires, versions etc). Mais le coût économique reste classiquement à la charge des établissements utilisateurs et/ou producteurs (respectivement abonnement et paiement par l’auteur).

Tout comme l’édition, l’évaluation évolue et a fait l’objet de plusieurs contributions stimulantes au cours de cette journée. A suivre dans le prochain billet !

Humanités numériques : prêt(sque)

1L’informatique est entré dans le monde des chercheurs en sciences humaines depuis longtemps déjà. On présente souvent le père Roberto Busa comme l’un des initiateurs de ces pratiques, qui avec l’aide d’IBM a automatisé l’analyse lexicale des textes de Thomas d’Aquin dès le début des années 1950.

Il est donc tout naturel que les recherches en linguistique soient déjà familiers de ces enjeux depuis longtemps. Y compris à Nice.

Néanmoins, le traitement informatisé n’est pas la seule dimension de ce qu’on appelle désormais les humanités numériques.

Il a fallu quelques années pour que la communauté scientifique intègre que les promesses apportées par le numérique changeaient non seulement les outils de la recherche, mais aussi ses perspectives.

Et c’est finalement tout une nouvelle culture qui se met en marche.

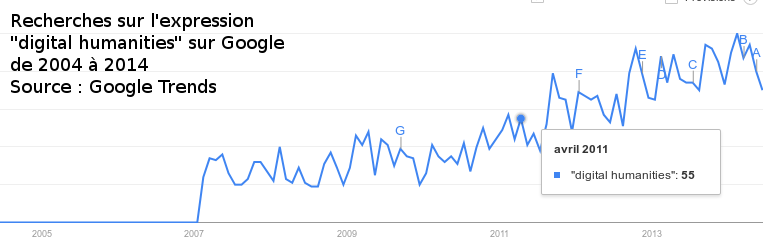

Les digital humanities, ou humanités numériques, sont une idée dans l’air du temps, dont la vogue n’est pas sans rappeler celle du web 2.0 il y a quelques années.

Néanmoins l’expression est également un concept permettant de désigner les conséquences sur la nature même de l’activité de recherche, notamment :

- l’accès facilité aux données

Auparavant, le temps du chercheur ou du doctorant pouvait être consacré à simplement constituer un corpus. L’alimentation de ce corpus justifiait en soi des mois ou années de recherche (à charge pour les successeurs de l’exploiter). - le passage de l’échantillon aux Big Data

les historiens travaillent souvent sur des archives éparses, clairsemées — bref : rares.

Exploiter l’état des paroisses et des feux de 1328 ne ressemble pas vraiment à l’utilisation qu’on peut faire des bases Insee relatives à la population française (et toutes autres sources parallèles). L’utilisation de ces données ne va pas de soi. - La production scientifique : les confrères n’attendent plus seulement de pouvoir bénéficier de l’article final. Les données brutes qui ont servi à l’élaborer, voire la base de données constituée pour l’occasion, doivent être mises à disposition.

Donc en ligne.

Donc dans des formats exploitables (et il y a une vie après le CSV). - La publication scientifique : Word, ce n’est pas une machine à écrire avec écran et la possibilité de cliquer sur Ctlr+Z. De même, le numérique, ce n’est pas que de la bureautique.

La diffusion en ligne permet de produire autre chose que du texte : des PDF contenant des images 3D, des frises chronologiques dynamiques — plus largement, toute une diversité de possibles sur la manière de donner à voir les résultats de la recherche - La diffusion scientifique au plus grand nombre.

Internet ouvre un champ nouveau de lecteurs : les citoyens.

Mais cette large diffusion n’est possible que si certains acteurs ne remettent pas des enclosures informationnelles, c’est-à-dire des barrières (juridiques, financières, techniques) qui dépossèdent le grand public du savoir produit dans les établissements de recherche.

Humanités numériques + bibliothèques = ?

Avec les humanités numériques, il est question de ressources, il est question de formats, de gestion, de traitement et d’enrichissement des données, de production scientifique, de pérennité, d’accès, de droits de réutilisation, de diffusion du savoir.

Bref, il est question de plein de dimensions dont les bibliothèques sont familières. Où elles peuvent accompagner les projets de recherche, par exemple :

- sur l’identification des référentiels à exploiter pour produire et publier des données

- sur les licences disponibles à associées à ces jeux de données, et plus globalement sur leur mode de gestion

- sur les questions de T&D mining (et notamment les services – ou pas – proposés par les grands éditeurs)

- sur la diffusion du savoir, notamment avec la mise à disposition immédiate via une archive ouverte

Pour aller plus loin

- HumanLit, un carnet d’Hypotheses.org sur les humanités numériques

- Une infographie sur les résultats d’une enquête menée par HumanLit portant sur les humanités numériques, portant sur la perception de cette notion auprès des chercheurs

- Renseigner une autre enquête sur les humanités numériques de Dariah-EU, visant à « comprendre comment les chercheurs européens utilisent les ressources, les méthodes et les outils numériques, et de quelle manière les infrastructures numériques peuvent répondre à leurs besoins » (afin de mieux développer leur offre de service).

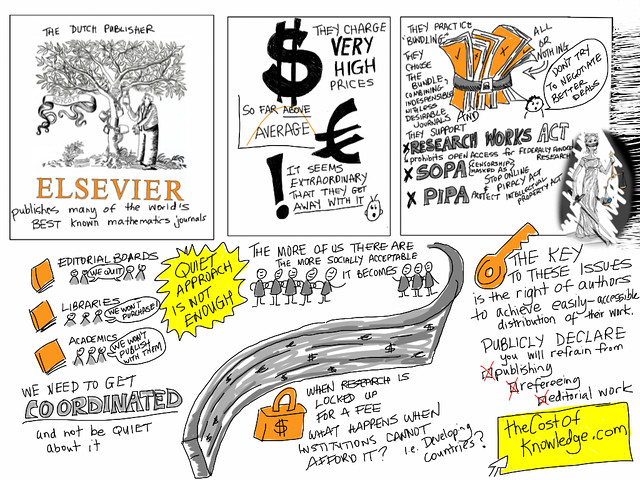

Le coût de la connaissance

4Il y a 2 ans, le mathématicien Tim Gowers lançait la pétition du Cost of Knowledge, invitant les chercheurs à ne plus participer aux comités éditoriaux de revues publiées chez Elsevier, quand dans le même temps le coût des abonnements à ces revues continuait de croître d’une manière de plus en plus insoutenable pour les universités.

Comme il le constate lui-même dans un long billet paru fin avril, en dépit du nombre conséquent de signatures, aucun comité éditorial de revue n’a pour autant quitté Elsevier, ou fait pression d’une manière telle que les choses aient au final beaucoup changé en 2 ans.

Image Flickr par Giulia Forsythe – CC-BY-NC-SA-2.0. Inspiré par l’initiative TheCostOfKnowledge de Tim Gowers

Tim Gowers prend le problème par un autre bout : rassembler des éléments d’informations (« some facts ») sur la situation actuelle des universités du Royaume-Uni et ce que les produits Elsevier leur coûtent.

S’ensuit une longue quête de plusieurs mois, donc un long billet de plusieurs milliers de mots, qui se lit comme un récit et qui dévoile de nombreuses informations.

3 dimensions principales y sont abordées :

- Le modèle économique actuel

Explications sur ce qui compose le prix d’un abonnement chez Elsevier, d’où il vient, ce que sont les négociations par consortiums d’établissements : existe-t-il un modèle idéal ? - Les modalités du modèle

Ce que ce modèle coûte aux universités. Pour y voir plus clair, Tim Gowers a écrit à de nombreux établissements (et à Elsevier même) pour obtenir des données chiffrées, en appelant notamment au Freedom of Information Act - Les informations dont on dispose (ou pas) sur les 2 premiers points

ou plus exactement la difficulté à obtenir de telles informations

Ce billet doit conduire à réfléchir sur la situation française, évoquée d’ailleurs par l’auteur, avec le nouveau contexte de licence nationale, dont le modèle (économique et de services) a déjà entraîné de nombreux débats sur internet.

Si la longueur, combinée à la langue, peut vous décourager, vous pouvez passer par la traduction intégrale en français de ce billet.

Sa lecture en vaut vraiment la peine !

L’article original (en anglais)

Elsevier Journals – Some facts

Baisse des achats de manuels en BU

1Les résultats de la dernière enquête de l’Association des Directeurs de Bibliothèques Universitaires (ADBU) sur les budgets des bibliothèques universitaires viennent d’être publiés.

Avec un constat : confrontées à une augmentation continue du prix de la documentation électronique recherche, les bibliothèques n’ont plus les moyens d’acheter des livres. C’est aussi le cas à l’UNS.

A lire sur le site de l’ADBU