Articles taggués traitement de données

Retour d’expérience: aide à la constitution d’un corpus bibliographique sur les études africaines

3Entre l’été 2014 et l’automne 2015, la BU a collaboré avec un groupe de chercheurs réalisant un livre blanc sur les études africaines. Nous reviendrons dans ce (long) billet sur la nature et le cadre de cette intervention, et les enseignements que nous en avons tiré.

[Billet mis à jour le 9/12/2016 : ajout de l’étape d’harmonisation des disciplines des thèses avec l’outil Openrefine]

Un livre blanc sur les études africaines en France

Différents laboratoires de sciences humaines et sociales français consacrent tout ou partie de leurs travaux à des aires culturelles spécifiques. Sous l’égide de l’institut des SHS du CNRS, quatre GIS (groupements d’intérêt scientifique) fédèrent les compétences et encouragent les partenariats entre spécialistes de l’Afrique, de l’Asie et du Pacifique, des Amériques, et du Moyen orient et du monde musulman. Le GIS sur les études africaines en France regroupe 33 laboratoires, dont l’Unité de Recherche Migrations et Société (URMIS), spécialisée dans l’étude des migrations et des relations interethniques, qui dépend à la fois des université de Nice et Paris-Diderot, de l’Institut de recherche et du développement, et du CNRS.

À la demande du CNRS, ces quatre GIS ont produit des « livres blancs » faisant le bilan des études dans leurs domaines respectifs. Une synthèse de ces livres blanc a été réalisée et une journée d’étude organisée à Paris le 24 octobre dernier. Les livres blancs sont accessibles librement et constituent des documents fort utiles pour faire le point sur les équipes de recherche, les moyens humains et les centres de documentation spécialisés concernant le Moyen-Orient et les mondes musulmans, les Amériques, l’Asie et le Pacifique, et l’Afrique.

À l’été 2014, Mmes Streiff-Fénart, Ballarin et Lesclingand, chercheuses de l’URMIS impliquées dans la rédaction du livre blanc sur les études africaines, ont pris contact avec les collègues de la BU Saint Jean d’Angély, qui avaient déjà noué des relations de longue date avec leur laboratoire. Elles souhaitaient collecter des informations sur les thèses et les articles concernant l’Afrique. Leur demande a été essentiellement étudiée par le département d’ingénierie documentaire des BU, qui leur a proposé d’extraire et d’enrichir semi-automatiquement des données bibliographiques à partir de différentes sources.

L’intervention de la bibliothèque

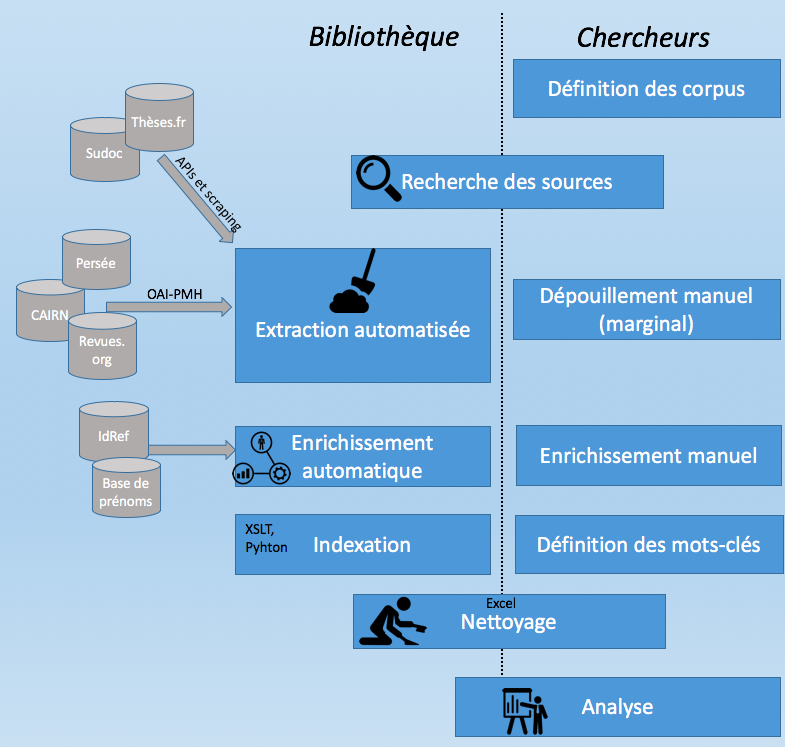

Nous avons fourni trois jeux de données, concernant

- Les thèses en SHS concernant l’Afrique, soutenues en France de 1930 à 2014 (15 546) ;

- Les articles concernant l’Afrique dans une sélection de 7 revues spécialisées sur l’Afrique, de 1960 à 2013 (3 919) ;

- Les articles concernant l’Afrique dans une sélection de 40 revues de SHS, de 1960 à 2013 (4 941).

Les informations fournies étaient des « métadonnées » (auteur, titre, revue, date, résumé, sujet), et non le texte intégral des articles.

Ce travail a mobilisé les compétences de plusieurs collègues chargés de la documentation électronique et de l’ingénierie documentaire (pour les sources numériques et les aspects techniques), ou en poste dans les BU Saint-Jean d’Angély et Droit (pour les sources imprimées). Il a nécessité une collaboration régulière avec les chercheuses (6 réunions et de nombreux échanges) afin de préciser leurs besoins (liste des revues, critères d’inclusion ou d’exclusion des articles et des thèses, mots clés thématiques et géographiques) et la répartition du travail. Enfin il s’est avéré très prenant tant pour nous que pour les chercheuses, notamment dans la phases de nettoyage des données.

Plusieurs sources ont été utilisées:

- Pour les thèses : le portail thèses.fr et le Sudoc (pour les thèses soutenues avant 1985, absentes de thèses.fr) ;

- Pour les revues : les sites Persée, Revues.org et CAIRN, quelques sites de revues isolés.

Notons que certaines revues ont dû être dépouillées manuellement par une stagiaire encadrée par le laboratoire.

La récupération d’information a mobilisé plusieurs techniques:

- Protocole OAI-PMH ;

- API de theses.fr ;

- Web scraping (Sudoc et sites de revues isolées).

Ces données ont été agrégées et dédoublonnées, enrichies et indexées:

- Détermination des disciplines des thèses (les informations étant présentées de manière très hétérogènes dans nos données, nous avons utilisé l’outil OpenRefine pour les harmoniser)

- Ajout du sexe des auteurs (extrait de la base IdREF, ou bien obtenu par croisement avec une liste de prénom) ;

- Indexation thématique et géographique à partir de mots clés présents dans les titres et les résumés. L’indexation géographique a pris en compte les ethnies, les pays, les macro-régions (Afrique de l’Ouest, Sahara…), et certaines formes « alternatives » (variantes de noms de pays, gentilés, capitales et villes principales…).

Puis nettoyées et filtrées (en grande partie manuellement…):

- Suppression de certains types de documents (éditoriaux, nécrologie, notes de lecture) ;

- Suppression d’articles en anglais ;

- Suppression d’articles et de thèses non liés aux sciences humaines (géologie, climatologie, etc.).

Différents outils ont été mobilisés:

Lors des premières étapes, la chaîne d’enrichissement des données a reposé essentiellement sur des traitements en XSLT. Ultérieurement, de petits scripts en Python ont également utilisés. Mais c’est Excel qui a servi d’outil de base pour la compilation, le contrôle qualité et le nettoyage des données. Nous avons également eu recours au logiciel Tableau pour visualiser des données dans une phase intermédiaire du projet.

L’analyse des données

Les données fournies par la BU ont fait l’objet d’une première analyse rapide afin de contrôler la qualité des données, puis d’une analyse plus approfondie par les membres du GIS, présentée dans la 3e partie (« L’Afrique dans les thèses et les revues ») du livre blanc.

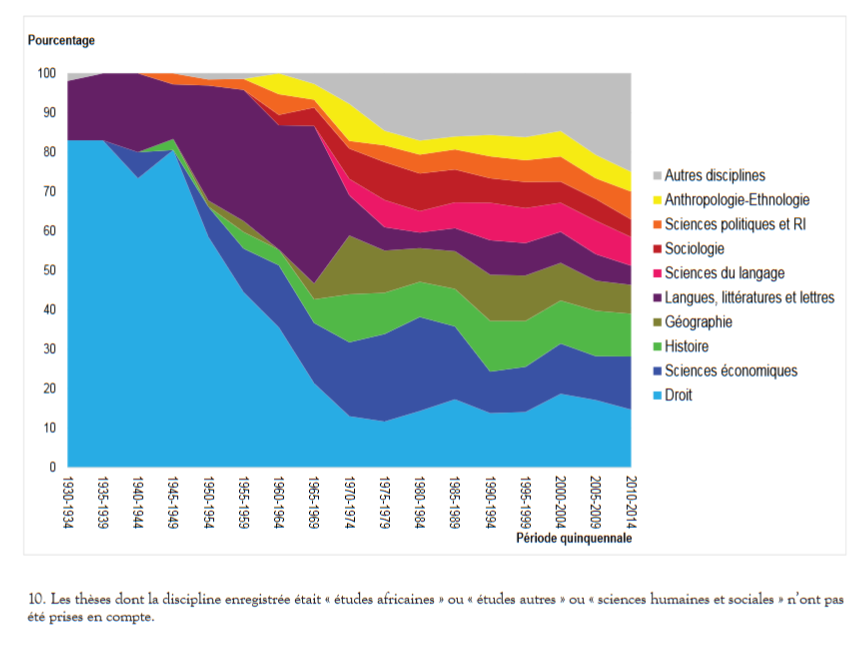

Concernant les thèses, les auteurs ont pu mettre en évidence:

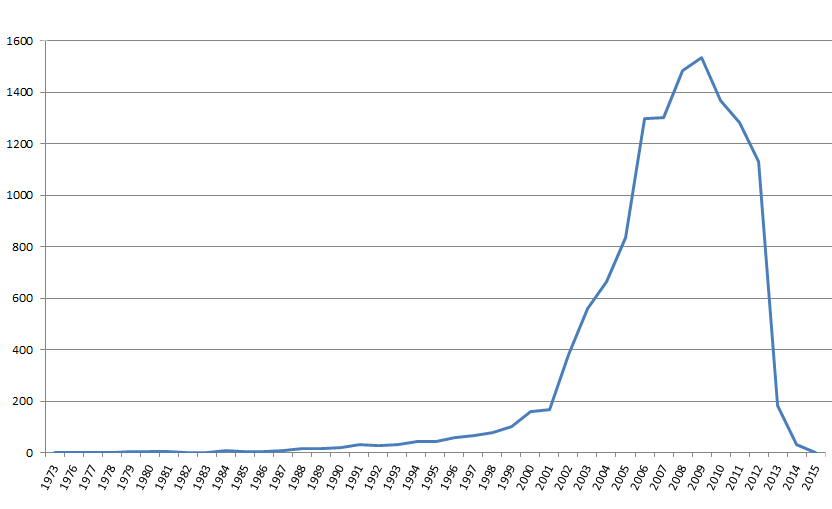

- Une forte progression du nombre de thèses à la fin des années 1970 et dans les années 1980, puis une stabilisation (environ 400 thèses par an sur l’Afrique aujourd’hui) ;

- Une domination du droit et des langues jusqu’aux années 1970, puis une diversification (histoire, géographie, sciences économiques, sciences politiques, anthropologie) ;

- Une suprématie francilienne et parisienne : Près de la moitié des thèses sur l’Afrique ont été soutenues dans une université francilienne, principalement dans Paris intra-muros. Bordeaux et Aix-Marseille constituent deux pôles secondaires importants ;

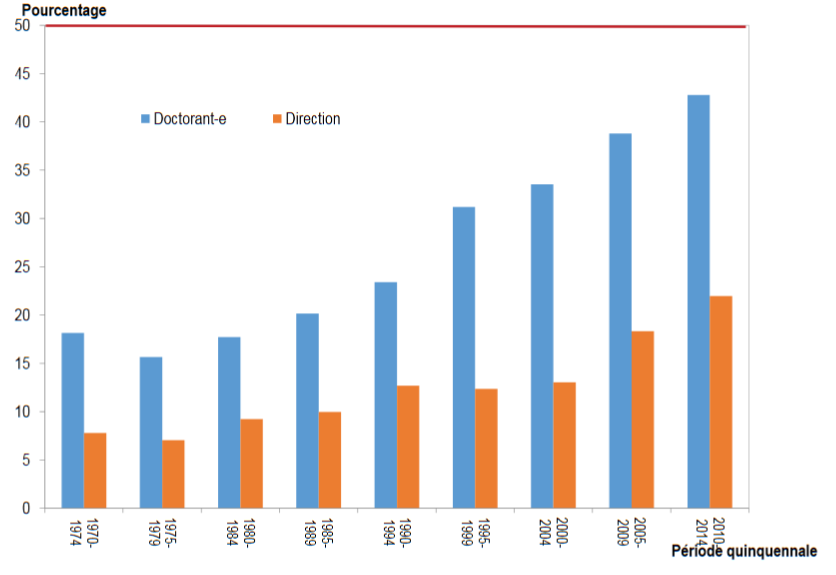

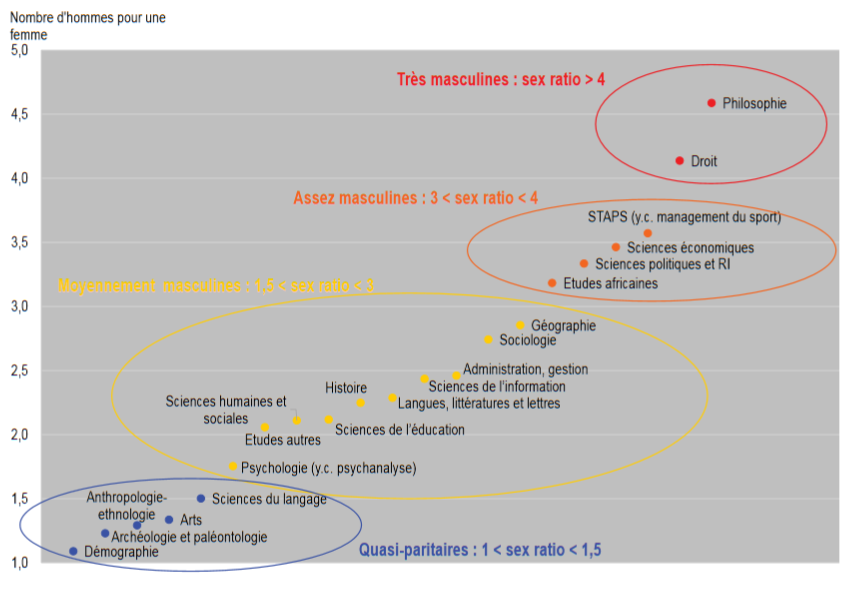

- Un sex-ratio très déséquilibré en défaveur des femmes, le différentiel tendant à s’atténuer dans la période la plus récente, mais beaucoup plus lentement pour les directeurs de thèses que pour les doctorants ;

- Un sex-ratio très différentié selon les disciplines : 1 doctorante pour 4 ou 4,5 doctorant en droit ou en philosophie (mais la philosophie ne représente que 0,7% des thèse, le sex-ratio est à prendre avec précaution), contre 1 pour 1 en démographie, et 1 directrice de thèse pour 11 à 12 directeurs en sciences économiques et politiques !

D’autres analyses ont porté sur les revues:

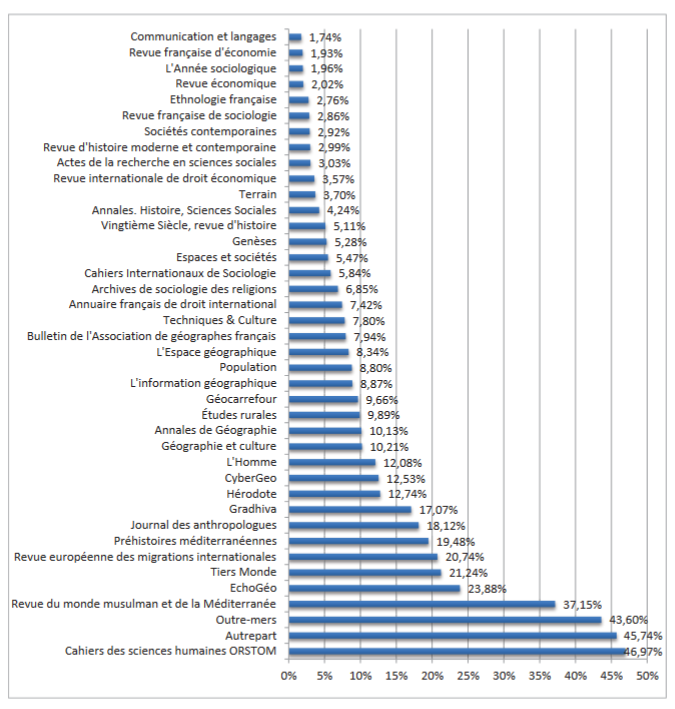

- La part des articles consacrés à l’Afrique dans des revues non spécialisées : L’Afrique est bien représentée (19 à 48 % des articles) dans les revues thématiques sur le développement, le Sud, les grandes aires culturelles, les migrations, et dans une moindre part (8 à 23%) dans les revues géographie, d’anthropologie et de démographie. Elle occupe une place réduite dans les revues d’histoire, de droit, d’économie et de sociologie.

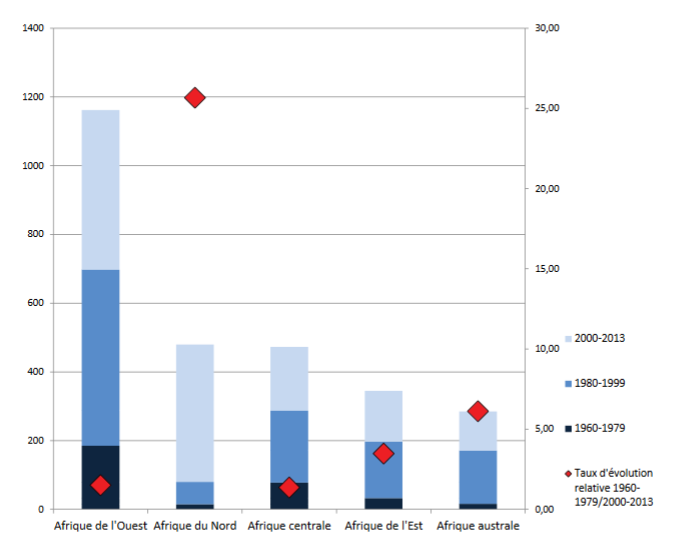

- L’importance respectives des différentes macro-régions dans les revues spécialisées sur l’Afrique: les articles concernant l’Afrique de l’Ouest (en particulier la Côte d’Ivoire, le Sénégal et le Mali) sont de loin les plus nombreux, mais le nombre d’articles consacrés à l’Afrique australe et l’Afrique de l’Est a fortement progressé au cours de la période (ainsi que ceux consacrés à l’Afrique du Nord, mais il s’agit en partie d’un artéfact statistique du à la prise en compte de la revue Maghreb-Machrek à partir de 2003)

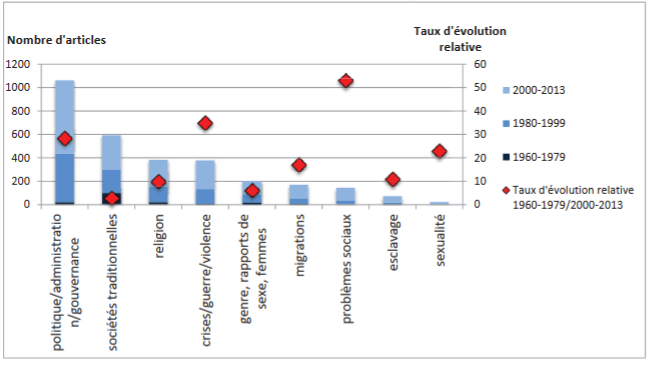

- Poids et évolution des différents thèmes dans les revues spécialisées: et surtout leur évolution: dans les années 1960, les articles évoquaient en priorité des sujets liés aux sociétés traditionnelles. Dans les années 2010, cette place est occupée par les sujets liés à la politique et à l’administration. Des thèmes quasiment inexistant il y a 50 ans ont désormais une place importante: la communication, le droit, la sexualité, les problèmes sociaux, les crises, la guerre et la violence.

Précautions d’usage

Notre travail, en tant que « producteurs » des données a aussi été d’avertir les chercheuses de la présence de divers biais, dont certains n’ont pas pu être corrigés :

- « Silence documentaire » (documents non intégrés au corpus) lié à des sources lacunaires (certaines revues n’étaient pas en ligne pour des périodes clés, et n’ont pas pu être dépouillées manuellement) et au non-repérage d’articles si les mots clés liés à l’Afrique n’étaient pas présents dans le titre ou le résumé ;

- « Bruit documentaire » (documents intégrés à tort au corpus) lié à la présence de mots clés liés à l’Afrique dans des titres ou résumés d’articles pourtant non liés à l’Afrique, de mots clés ambigus, et à la difficulté d’exclure certains types de documents (nécrologies, éditoriaux, notes de lecture…) ;

- Silence et bruit dans l’indexation des documents intégrés au corpus ;

- Hétérogénéité quantitative et qualitative du corpus: création et disparition de revues, métadonnées de plus en plus précises et détaillées au fil du temps (le taux de résumés disponibles croit fortement à partir des années 1980, ce qui induit mécaniquement un accroissement du nombre de mots clés reconnus) ;

- Importance du nettoyage manuel, et donc possibilité d’erreurs humaines.

Quel bilan?

Concernant la communication avec les chercheuses, notre position d’« extériorité » a pu être un handicap, qui a entraîné quelques malentendus, et un surcroît de travail pour toutes les parties prenantes. Nous avons pu également constater des différences « culturelles » entre bibliothécaires et chercheurs (par exemple, un bibliothécaire fera tout pour conserver les identifiants permettant de recroiser des données, alors qu’une démographe aura le réflexe de les supprimer).

L’idée initiale d’une « extraction automatisée de données » a dû être fortement nuancée, surtout sur un corpus aussi hétérogène. Certaines sources ont dû être dépouillées manuellement, d’autres n’ont pas pu l’être, et les données finalement recueillies ont été plus hétérogènes que prévu, ce qui a entraîné un travail important de nettoyage de notre part et de la part du GIS, et a limité la faisabilité ou la fiabilité de certaines analyses.

Nous avions pensé utiliser certaines sources qui n’ont finalement pas pu être retenues pour des raisons techniques, de qualité et de complétude des données (les premiers essais à partir des données d’Isidore n’ont pas été concluants) ou de disponibilité (un export global des thèses du Sudoc nous aurait fait gagner du temps).

Les méthodes mises en œuvre liaient fortement les phases d’extraction et d’indexation. Ces deux volets gagneraient à être distingués : même si l’extraction est basée sur certains mots-clés, ce ne sont pas forcément ces mots-clés qui doivent servir lors de l’analyse.

Enfin, les outils et méthodes développés n’ont pas été pensées dès le départ pour être réutilisables. Si un projet du même type se représentait, nous chercherions à les rendre plus génériques.

Et après?

La contribution au livre blanc sur les études africaines nous a permis de confirmer notre intuition de départ: les bibliothèques disposent de compétences qui peuvent être utiles à certains projets de recherche.

D’autres expérimentations du même type sont en cours, et seront le sujet de billets à venir.

50 ans d’activité scientifique, 50 ans d’open access, 50 ans de collaborations

0J’ai décrit dans un précédent billet le contenu de HAL-Unice, en terme de volumétrie.

Rappelons que les constatations sont faites pour le corpus constaté, c’est-à-dire les archives déposées dans HAL, et les articles signalés par les chercheurs dans HAL. Ce corpus ne prend donc en compte

- ni l’ensemble de la publication scientifique de l’Université

- ni même l’ensemble de la politique d’open access des structures de recherche de l’Université, car il existe d’autres dépôts d’archives en France et dans le monde

Si les archives déposées dans ArXiv par des chercheurs français se retrouvent automatiquement dans HAL, ce n’est pas le cas par exemple de CiteSeerx, dans lequel on trouvera de nombreux articles déposés par des chercheurs affiliés à l’Université de Nice, qui ne sont pas du tout signalés dans HAL.

Par ailleurs les disciplines sont inégalement représentées du fait aussi des pratiques de publication des chercheurs, directement liées aux conditions d’évaluation (ex : publier un ouvrage compte-t-il ou non ?) et aux pratiques des communautés scientifiques et des maisons d’édition.

Pour les archives qui y sont déposées ou signalées, HAL-Unice constitue-t-il un bon corpus pour donner à voir toutes les collaborations entre laboratoires et structures de recherche ? On peut toujours essayer.

A chaque notice est associée l’affiliation du ou des auteurs. Cette affiliation est presque toujours exprimée de manière double, quand elle désigne le nom du labo et l’université de rattachement de celui-ci ; ou triple quand il s’agit d’une UMR, rattachée à la fois au CNRS et à l’Université.

En moyenne, une ressource est affiliée à 6 structures de recherche, avec un maximum de 56 pour l’ensemble étudié…

On peut donc considérer que chaque article est le fruit d’une collaboration entre les structures de recherche auxquelles appartiennent leurs auteurs. Chaque article donne à voir une collaboration entre deux structures de recherche.

De manière plus globale (c’est-à-dire en regardant les liens entre les structures de recherche, non pas notice par notice mais pour l’ensemble du corpus), on découvre tout un réseau continu entre les établissements.

Explications

Les données qui ont permis de générer ce graphe :

A chaque article est associé un ou plusieurs « sets ». Quand il y a plusieurs affiliations d’établissements, cela apparaît sous la forme :

<collection>UNICE</collection> <collection>SHS</collection> <collection>EPHE</collection> <collection>INRAP</collection> <collection>CNRS</collection> <collection>UNIV-TLSE2</collection> <collection>CEPAM</collection> <collection>TRACES</collection> <collection>CBAE</collection> <collection>UNIV-MONTP3</collection> <collection>UMR5140</collection> <collection>UNIV-AMU</collection> <collection>MMSH</collection> <collection>LADIR</collection> <collection>UPMC</collection>

On a considéré qu’à travers cette liste, chaque structure de recherche était liée à chacune des autres, ce qui a généré toutes les paires possibles :

UNICE;SHS / UNICE;EPHE / UNICE;INRAP / UNICE;CNRS / UNICE;UNIV-TLSE2 / UNICE;CEPAM / UNICE;TRACES / UNICE;CBAE / UNICE;UNIV-MONTP3 / UNICE;UMR5140 / UNICE;UNIV-AMU / UNICE;MMSH / UNICE;LADIR / UNICE;UPMC / SHS;EPHE / SHS;INRAP / SHS;CNRS / SHS;UNIV-TLSE2 / SHS;CEPAM / SHS;TRACES / SHS;CBAE / SHS;UNIV-MONTP3 / SHS;UMR5140 / SHS;UNIV-AMU / SHS;MMSH / SHS;LADIR / SHS;UPMC / EPHE;INRAP / EPHE;CNRS / EPHE;UNIV-TLSE2 / EPHE;CEPAM / EPHE;TRACES / EPHE;CBAE / EPHE;UNIV-MONTP3 / EPHE;UMR5140 / EPHE;UNIV-AMU / EPHE;MMSH / EPHE;LADIR / EPHE;UPMC / INRAP;CNRS / INRAP;UNIV-TLSE2 / INRAP;CEPAM / INRAP;TRACES / INRAP;CBAE / INRAP;UNIV-MONTP3 / INRAP;UMR5140 / INRAP;UNIV-AMU / INRAP;MMSH / INRAP;LADIR / INRAP;UPMC / CNRS;UNIV-TLSE2 / CNRS;CEPAM / CNRS;TRACES / CNRS;CBAE / CNRS;UNIV-MONTP3 / CNRS;UMR5140 / CNRS;UNIV-AMU / CNRS;MMSH / CNRS;LADIR / CNRS;UPMC / UNIV-TLSE2;CEPAM / UNIV-TLSE2;TRACES / UNIV-TLSE2;CBAE / UNIV-TLSE2;UNIV-MONTP3 / UNIV-TLSE2;UMR5140 / UNIV-TLSE2;UNIV-AMU / UNIV-TLSE2;MMSH / UNIV-TLSE2;LADIR / UNIV-TLSE2;UPMC / CEPAM;TRACES / CEPAM;CBAE / CEPAM;UNIV-MONTP3 / CEPAM;UMR5140 / CEPAM;UNIV-AMU / CEPAM;MMSH / CEPAM;LADIR / CEPAM;UPMC / TRACES;CBAE / TRACES;UNIV-MONTP3 / TRACES;UMR5140 / TRACES;UNIV-AMU / TRACES;MMSH / TRACES;LADIR / TRACES;UPMC / CBAE;UNIV-MONTP3 / CBAE;UMR5140 / CBAE;UNIV-AMU / CBAE;MMSH / CBAE;LADIR / CBAE;UPMC / UNIV-MONTP3;UMR5140 / UNIV-MONTP3;UNIV-AMU / UNIV-MONTP3;MMSH / UNIV-MONTP3;LADIR / UNIV-MONTP3;UPMC / UMR5140;UNIV-AMU / UMR5140;MMSH / UMR5140;LADIR / UMR5140;UPMC / UNIV-AMU;MMSH / UNIV-AMU;LADIR / UNIV-AMU;UPMC / MMSH;LADIR / MMSH;UPMC / LADIR;UPMC

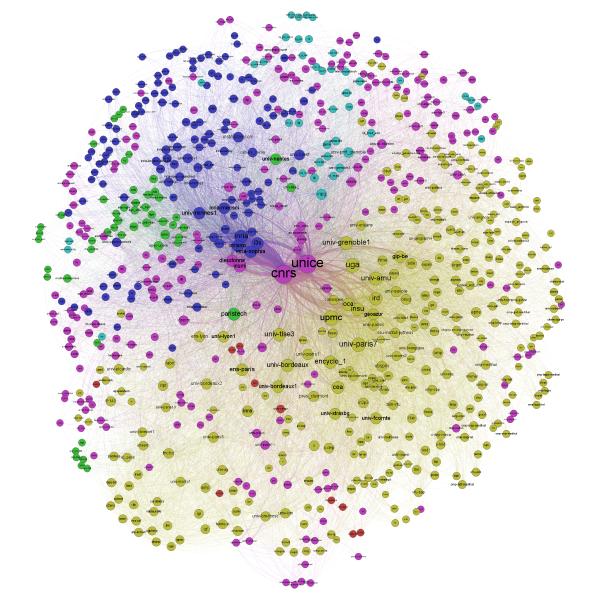

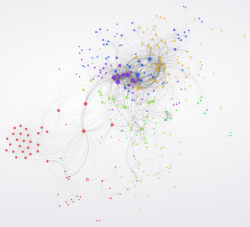

L’ensemble de ces paires a ensuite été chargée dans Gephi, pour obtenir une clusterisation et une répartition spatiale qui a rapproché les établissements travaillant le plus souvent ensemble, et attribuant (ou tentant d’attribuer) des couleurs par sous-groupes.

Le corpus considéré de manière « brute » (sans sélection des données traitées) laisse entendre qu’il n’y a pas vraiment de sous-ensembles nets : aucun groupe de noeuds ne se détache vraiment des autres, il y a plutôt, dans l’activité de publication, un continuum de la recherche.

Limites et reprises

On peut voir d’emblée au moins 3 limites aux données en entrée :

- il y a un trop grand nombre de noeuds (1177 « établissements » distincts) et de liens (31.000 liens distincts) pour obtenir un graphe satisfaisant

- Les données en entrée ne sont pas propres : les collections « SHS », « AO-ECONOMIE », ne sont pas des établissements

- Les universités sont sur le même plan que les laboratoires : donc toutes les universités sont finalement liées entre elles (via leurs laboratoires, y compris ceux qui ne travailleraient que dans un champ disciplinaire bien précis, et avec une liste fermée d’autres laboratoires du même champ disciplinaire).

Cette absence de partition en sous-groupes est donc inévitable tant qu’on prend en compte les universités.

Voici donc 2 autres tentatives pour voir si une visualisation différente pourrait se dégager :

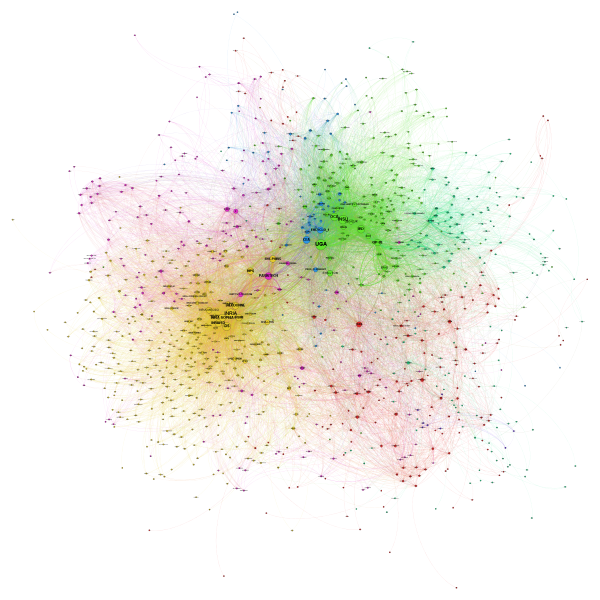

1. Données en entrée nettoyées des mentions de domaines de recherche, et des noms d’Université (ou CNRS)

Dans le graphe ci-dessous, les universités et le CNRS ont été retirées. Ne sont conservées que les structures de recherche de type Laboratoire ou Institut.

On passe ainsi à 1063 établissements (nœuds) et 18.000 liens :

Certains sous-ensembles se dégagent mieux (le graphe est moins uniforme) : SophiaTech et l’INRIA avec le labo de math J.A. Dieudonné ; les laboratoires de l’OCA (en vert) – et juste à côté, dans un vert légèrement différent, des structures de recherche en SHS (la plus visible sur le graphe étant le CEPAM).

Pourtant de nombreux liens existent manifestement entre ces groupes, et on continue d’observer le continuum évoqué plus haut.

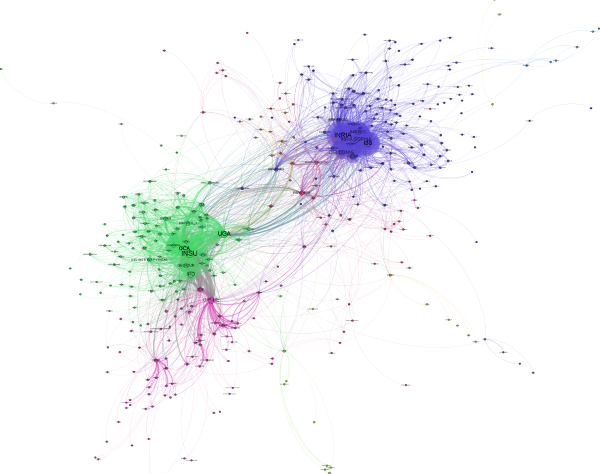

2. Données en entrée : les liens les plus importants

Une méthode supplémentaire pour « nettoyer » les données consiste à évacuer toutes les collaborations trop ponctuelles (1 à 5 occurrences), pour ne conserver que celles qui se sont répétées pour la rédaction de plusieurs archives déposées.

Ci-dessous le graphe exploitant les collaborations répétées au moins 6 fois dans le corpus étudié (404 structures de recherche, 2830 liens) :

Le risque est évidemment de faire disparaître des laboratoires très présents dans le corpus initial, mais qui travaillent ponctuellement avec un grand nombre d’autre laboratoires très diversifiés : chaque lien concernant ce labo apparaissant peu de fois, il finit par disparaître complètement du graphe…

661 structures sont évacuées suite à ce filtre supplémentaire, mais aucune ne relève de l’Université Nice Sophia Antipolis (qui est le sujet de ce billet).

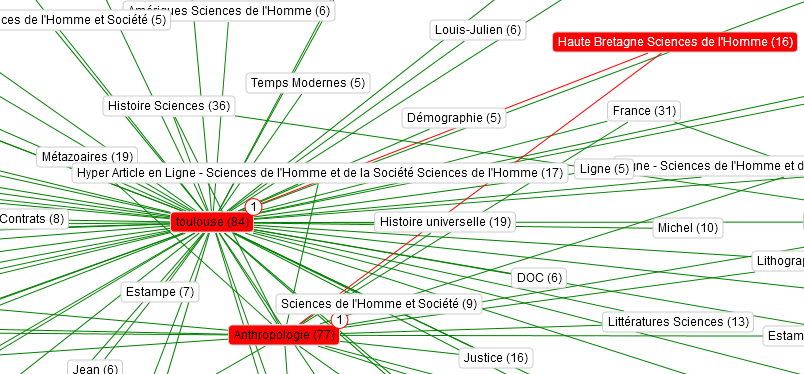

Ultime remarque : les SHS semble avoir disparu dans la masse. Du coup, voici un graphe rien que pour eux.

Celui-ci est dynamique et permet notamment de filtrer sur le nom d’un labo (via le petit moteur de recherche dans l’en-tête), pour voir identifier ses partenaires et sa position dans le réseau.

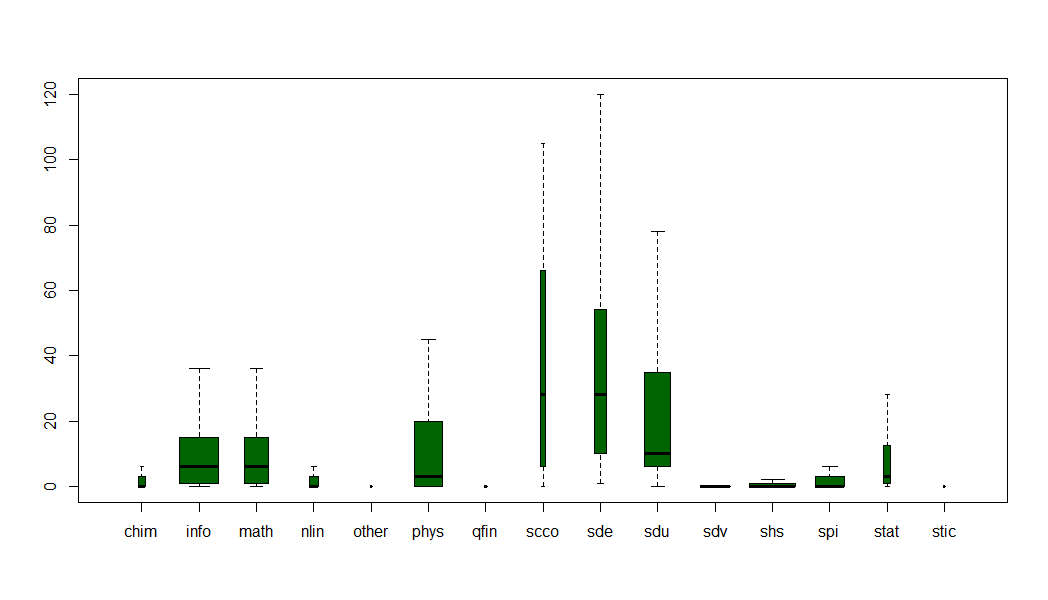

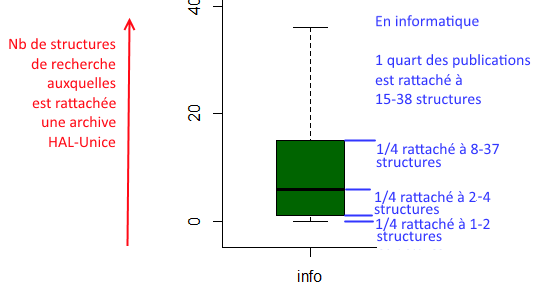

Pourquoi dans le graphe global ne voit-on presque plus que des structures de recherche en sciences ? Parce que dans les archives déposées ou signalées dans HAL-Unice, les SHS indiquent beaucoup moins d’affiliations : les collaborations entre labos sont en moins grand nombre :

- Pour chaque discipline, on voit le nombre d’établissements auxquelles sont rattachées les archives, avec leur dispersion.

Par exemple, en physique, le nombre d’établissement par archive va de 1 à 48. La moitié des archives sont rattachés à 1-8 établissements, l’autre moitié des archives de physique sont rattachées à 8-48 établissements.

En SHS, les 3/4 des publications sont rattachés à une seule structure de recherche

On voit donc que les Sciences du Vivant (SDV), les SHS, la science non linéaire (NLIN) sont plus tassées, donc sont rattachées à un moins grand nombre de structures de recherche, que l’économie, les sciences de l’environnement (SDE) ou les sciences de l’Univers (SDU) - La largeur des colonnes rend compte du nombre d’archives recensées : il y en a beaucoup plus en informatique, en physique et en SHS qu’en économie et en statistiques

Les archives en SHS contiennent moins de liens entre structures de recherche que celles en informatique, ce qui permet d’expliquer en grande partie leur « disparition » dans le graphe globale des collaborations

Limite essentielle de l’exercice

Si la démarche est intéressante (et justifie la publication de ce billet), les observations ci-dessus sont trop tributaires de la source des informations, qui est très partielle. J’ai déjà signalé que le corpus n’était ni exhaustif ni représentatif.

Il y a un autre biais, tout aussi gênant : le champ « setSpec » où sont stockées les informations exploitées ci-dessus est uniquement la mention des tampons associés à chaque ressource. Donc si un laboratoire de recherche n’a pas choisi de demander l’activation d’un tampon pour ses publications, il n’est pas mentionné dans ces setSpec.

Peut-on exploiter une autre source d’informations pour rattacher chaque archive déposée à des structures de recherche ? 2 autres sources seraient envisageables :

- Le champ « contributeurs » mentionne souvent le nom des laboratoires

- à partir du nom du chercheur, retrouver le nom de son laboratoire grâce à l’API Affiliation des auteurs

La première piste est bloquée du fait que, contrairement au champ setSpec, l’information n’y est pas normalisée : sur 22295 « contributeurs » dans le corpus, il y a 8244 formes différentes, ce qui ne veut pas dire 8244 structures de recherche : l’INRIA de Sophia-Antipolis apparaît sous 75 formes différentes.

La seconde piste serait plus prometteuse, s’il n’y avait le problème des homonymes, et des affiliations multiples (qui sont parfois en fait la même structure bénéficiant de plusieurs « fiches » dans HAL) ou successives.

Conclusions

L’analyse des collaborations entre structures de recherche, au travers du cas du corpus de HAL-Unice, donne à voir (à visualiser) le réseau de la recherche française, à travers le prisme de leur activité dans HAL (nombre de dépôts et tampon).

On pourrait pousser cependant plus loin l’analyse, pour calculer, par exemple en fonction des disciplines, le nombre de structures de recherche (moyen, médian) auquel un laboratoire (ou l’un de ses chercheurs) de l’Université s’associe.

Une évolution sur la durée pourrait aussi se révéler intéressante, mais sur un autre corpus : celui de HAL-Unice, pour cela, est sans doute trop concentré sur le XXIe siècle.

En revanche une projection cartographique, avec des données de géolocalisation, donnerait à voir l’extension de ces collaborations, et le poids des partenariats locaux. Il faudrait pour cela lier chaque structure à ces informations.

Pour avoir une vision plus satisfaisante, il faudrait entreprendre un gros travail de reprise des données disponibles, en systématisant par exemple la constitution de « collections » (tampons) par structure de recherche.

Le travail d’analyse est aussi très tributaire des données : et telles qu’elles sont il n’est pas toujours simple de distinguer automatiquement les structures UNS des autres, de les rattacher à une ou plusieurs disciplines. On pourra donc envisager des opérations de nettoyage et d’amélioration de la base initiale, pour pouvoir ensuite l’exploiter un peu mieux.

Ces 2 billets étaient surtout l’occasion de donner à voir ce que contenait HAL-Unice, comme reflet d’une partie de la production scientifique de l’Université.

Les thèses, produites elles durant 5 décennies, en sont un autre volet au moins aussi intéressant. Il en sera donc bientôt question.

50 ans d’activité scientifique, 50 ans d’open access

1Depuis plusieurs années (pas depuis 50 ans : les archives ouvertes n’existaient pas à l’époque), l’Université dispose d’une archive ouverte afin que ses chercheurs puissent y déposer leurs articles ou projets d’articles de manière rapide, efficace, et sans contrainte d’accès.

Actuellement, cela représente près de 13.000 archives décrites ou déposées dans HAL rattachées à une structure de l’Université. Cette masse constitue en soi une source d’information sur la production scientifique de l’établissement.

Ce n’est évidemment pas une source exhaustive sur la production scientifique de l’Université, et sa volumétrie (notamment par discipline) ne rend pas compte de l’activité de publication des chercheurs.

Néanmoins l’exploitation de ces données peut nous apprendre pas mal de choses sur l’activité à l’UNS.

A l’issue du parcours, je vous parlerai de ceci :

Mais avant ça, commençons pas des considérations plus basses, sur ce que contient ce corpus.

Répartition annuelle

Les plus anciens articles déposés datent de 1973. Ce n’est évidemment pas la date de leur dépôt, mais bien de leur rédaction

Voici la plus ancienne notice signalée dans HAL-Unice.

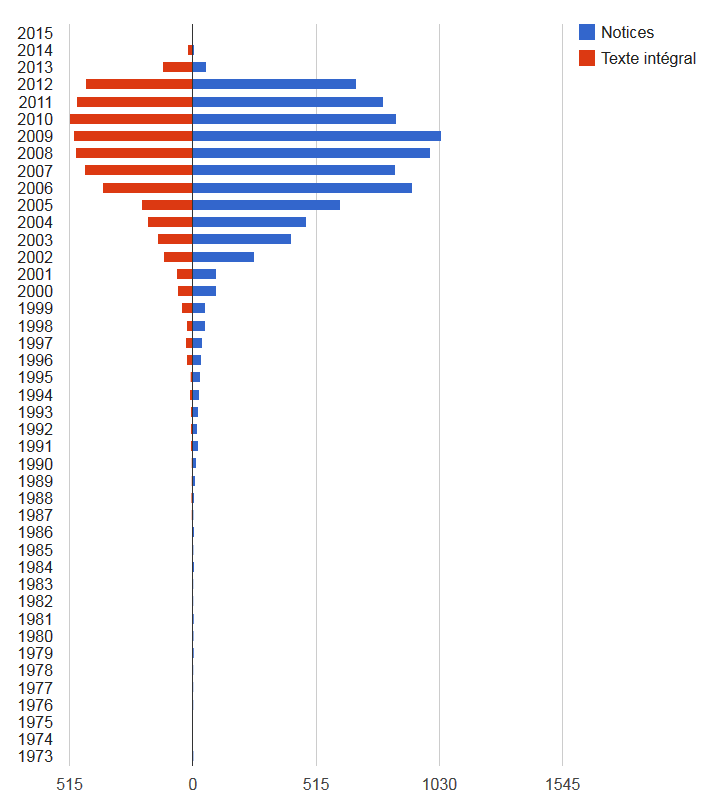

Texte intégral vs. notice bibliographique

Car il s’agit bien là d’une notice. Et de manière générale, il y a chaque année près de 2 fois plus de notices déposées que d’archives en texte intégral :

HAL-Unice sert donc aussi en grande partie, pour certains chercheurs à recenser leur production, notamment quand le dépôt ne leur semble pas possible (une hésitation sur ce qui est possible ou non ? suivez le guide).

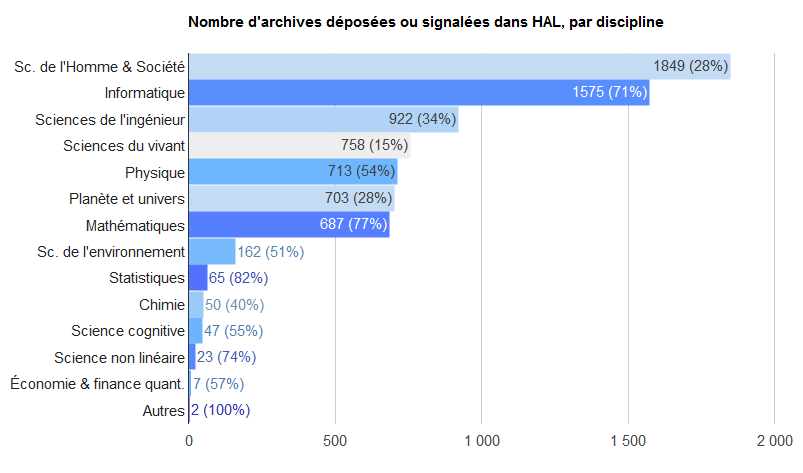

Les disciplines représentées

Ci-dessous une représentation des disciplines, dont les chercheurs déposent de manière assez différenciée.

- La longueur des barres rend compte du nombre d’archives signalées

- La couleur rend compte de la proportion des archives disponibles en texte intégral, rapporté aux articles signalés pour la discipline

- quand c’est clair : il y a surtout des notices ;

- quand c’est foncé : surtout du texte intégral).

Le pourcentage de texte intégral est indiqué entre parenthèses.

Les comportements des déposants dans HAL sont donc très diversifiés : HAL sert manifestement plus de base de signalement en SHS, où l’on sait par ailleurs que la démarche open access a une antériorité moindre que dans les sciences dures, qui ont initié ce mouvement avec ArXiv puis CiteSeer. La différence dans la proportion de texte intégral peut être liée aussi à la politique de certains laboratoires, plus incitatifs que d’autres.

Le web de données, Isidore adore !

1L’API d’Isidore pour en explorer les données, c’est chouette. L’accès par un Sparql Endpoint, c’est encore mieux !

Mais avant toute chose, un petit crochet par les concepts et technologies de base du Linked Open Data s’impose (car c’est de cela qu’il s’agit).

Et commençons donc par le formalisme RDF (pour Resource Description Framework) qui ne désigne rien de moins que le modèle de description et de publication des ressources et des métadonnées sur le web. Cette modélisation s’appuie sur 3 fondamentaux :

- Des triplets : une ressource est décrite par un ensemble de triplets, chaque triplet étant constitué par une association du type <sujet><prédicat><objet>, à l’image d’une structure grammaticale sujet-verbe-complément. Par exemple <ce livre><a pour titre>< Merci pour ce moment>, <ce livre><a été écrit par><Valérie Trierweiler> etc.. sont des triplets caractérisant l’opus en question.

- Des ontologies et des thésaurus : ce sont des modélisations (elles-mêmes structurées en triplets RDF) de représentations des connaissances (par exemple le Dublin Core). Dans les triplets RDF, Les prédicats se fondent donc sur les ontologies existantes pour typer les relations sujets-objets, c’est-à dire les sémantiser.

- Des URI : des identifiants pérennes sur le web pour chaque métadonnée. Une URI peut être une URL qui donne accès au contenu de la ressource (on parle alors URI déréférencée), mais pas que…Les sujets et prédicats des triplets RDF sont toujours des URI, tandis que les objets sont soit des URI soit des littéraux. Ainsi nos triplets précédents s’expriment (dans la notice RDF du Sudoc)

<http://www.sudoc.fr/180856936/id> <dc:title> “Merci pour ce moment" <http://www.sudoc.fr/180856936/id"> <marcrel:aut> <http://www.idref.fr/115490108/id>

L’ensemble des triplets constitutifs d’une base de données RDF (Isidore, le Sudoc, l’INSEE, DBPedia…) sont stockés dans un triplestore et forment donc un graphe qu’il est possible de requêter grâce au langage Sparql (assez similaire au SQL, le langage de requête des bases de données relationnelles) via un point d’accès web, un Sparql Endpoint.

Retour donc à Isidore dans le web de données : Isidore moissonne ses diverses sources selon le protocole OAI-PMH, c’est-à dire rapatrie des sets de données en format Dublin Core, les convertit en triplets RDF, les enrichit par croisement avec des référentiels externes, puis stocke tout ça dans un triplestore accessible avec Sparql par le Sparql Endpoint Virtuoso d’Isidore.

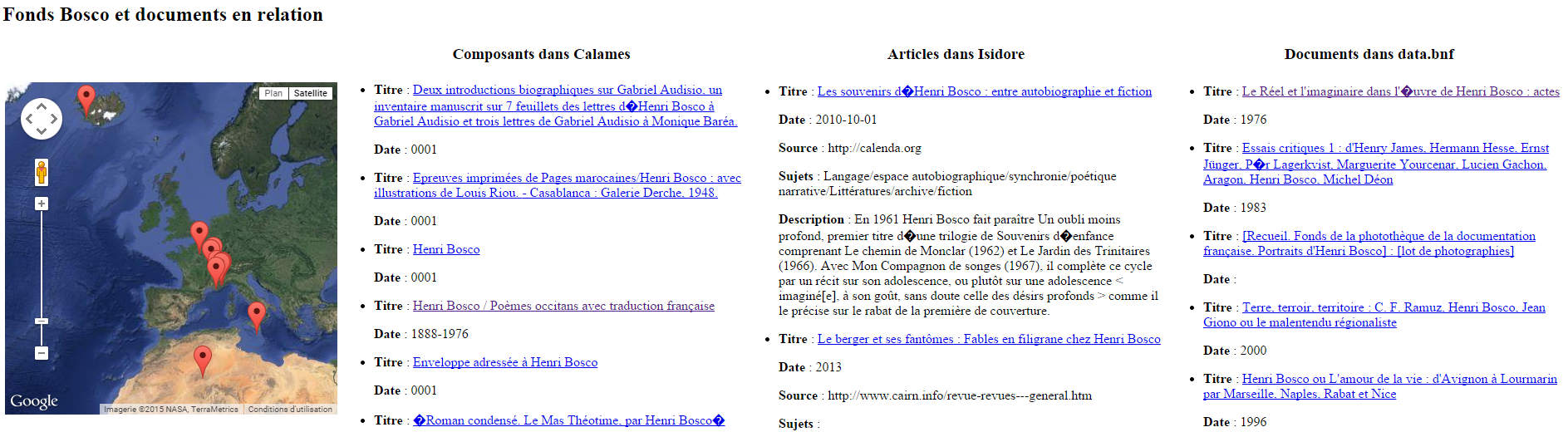

Et illustration de l’intérêt de tout ça avec un cas pratique : comment exploiter les données d’Isidore afin d’obtenir et étudier un corpus constitué de composants Calames et de publications autour des fonds patrimoniaux que possède ma BU (par exemple Henri Bosco, Gabriel Germain, Georges Perros, Samivel… et Michel Butor tant qu’on y est) ?

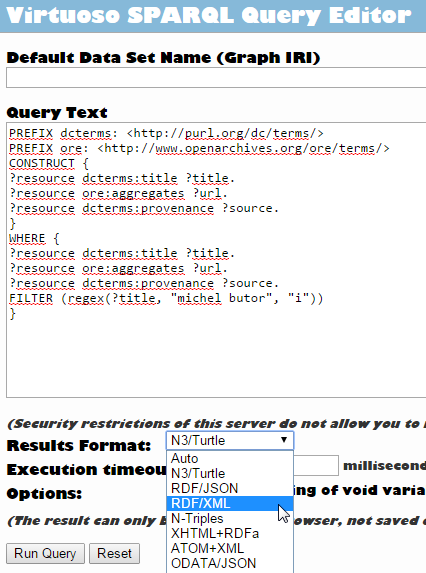

Pour commencer, on formule sa requête dans le Sparql Endpoint, ici une requête de type CONSTRUCT qui permet d’obtenir un set de résultats formant lui-même un graphe « personnalisé » à partir du graphe d’Isidore, puis on choisit la sérialisation (le format de sortie, RDF/XML en l’occurence) de ce nouveau graphe :

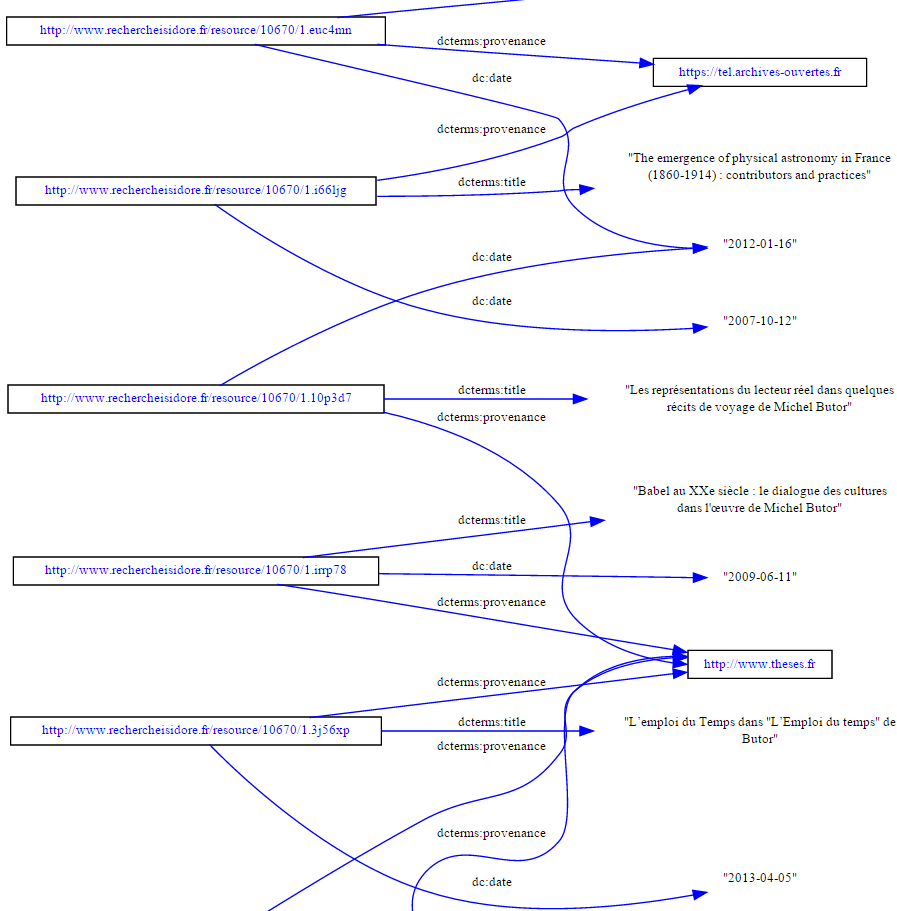

Graphe que l’on peut donc visualiser comme tel :

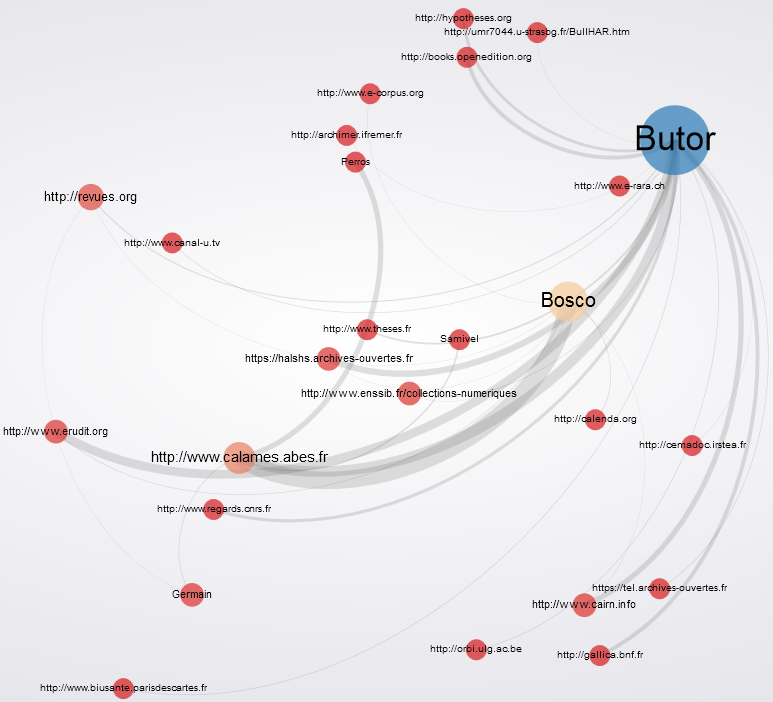

Ou plus joli, plus dynamique et en ligne :

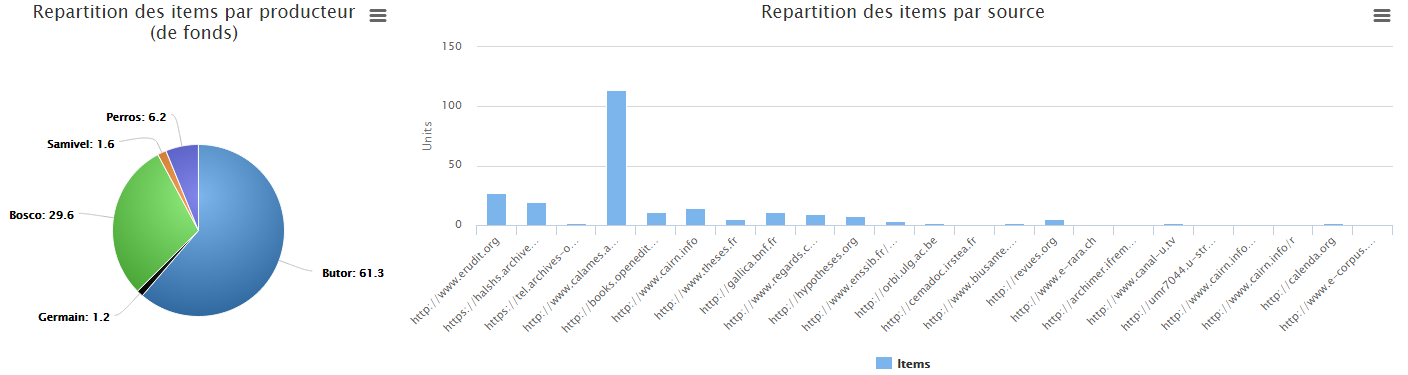

On peut aussi (essayer de) faire de jolis graphiques de visualisation statistique du corpus constitué : poids relatifs de chaque auteur dans les résultats, répartition par source de données…

Dans la même lignée, puisque Isidore enrichit ses données avec le référentiel Geonames, rien n’empêche de cartographier l’ensemble des résultats. Et puisque data.bnf propose aussi son Sparql Endpoint, pourquoi ne pas faire une réquête conjointe sur le graphe d’Isidore et celui de data.bnf afin de s’approcher d’une vue FRBRisée (hiérarchisée) des documents relatifs à ces fonds ? Par exemple pour le fonds Henri Bosco :

Pour visualiser la page web, c’est ici

Ainsi, les métadonnées d’Isidore formalisées en RDF, c’est la possibilité de :

- s’affranchir du niveau des notices et parcourir le graphe ouvert d’Isidore au niveau des données et non plus des notices

- exploiter l’interopérabilité de données sorties de leurs silos et structurées selon le même formalisme, indépendamment de leurs formats natifs (le web de données)

- pouvoir lier les données entre elles grâce aux URI et aux alignements des ontologies entre elles (le linked open data)

- d’exploiter sémantiquement le typage des relations entre sujets et objets, d’appliquer des algorithmes d’exploration sémantique grâce aux prédicats définis par des ontologies elles-mêmes définies sur le web (compréhensibles par des machines) pour un traitement « intelligent » des données (le web sémantique)

Au-delà des formats et des normes, il est sans doute là l’enjeu pour nos données bibliographiques comme pour les autres (données de gestion , données de la recherche…) : s’inscrire dans cette nouvelle brique de l’architecture du web où ce ne sont plus les pages html ou les documents qui sont liés mais les données et participer à la constitution d’un graphe, un jour, devenu universel.

Logiciels libres utilisés : Rhizomik RedeFer (et ses supers API), gexf-js Viewer, Highcharts

NB : pour ceux qui la chercheraient, il y encore une culotte quelque part…

Happy Isidore ! (Prononcer : A-P-I Isidore)

2Ou comment extraire, exploiter, retraiter et visualiser les données d’Isidore avec un cas pratique…

Isidore : une interface unique en SHS de 3 millions de notices

Isidore est un portail d’accès unifié aux publications électroniques (principalement francophones) en sciences humaines et sociales, développé depuis 2011 dans le cadre de la Très Grande Infrastructure dédiée aux humanités numériques, le TGIR Human-num.

Isidore moissonne et agrège les données de multiples sources et bases de données telles que Revues.org, Persée, Gallica, Calames, Cairn, Dumas, Erudit…, soit en tout plus de 3 millions de documents.

Des informations enrichies

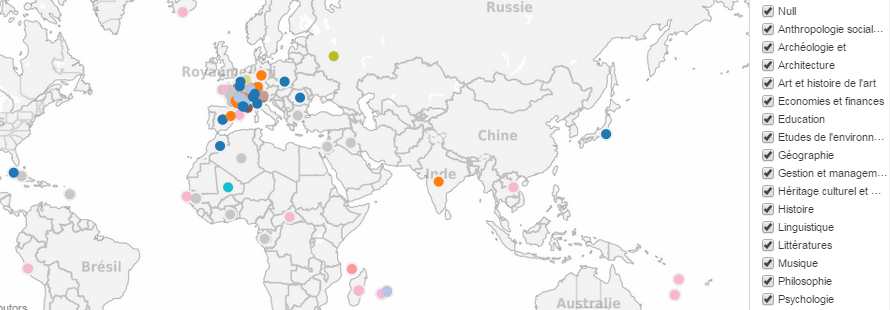

Mais plus intéressant encore, Isidore s’appuie sur les technologies de ce que l’on appelle le LOD (Linked Open Data), pour enrichir les données engrangées d’information, grâce à des sources complémentaires.

Parmi celles-ci, citons :

- le référentiel disciplinaire européen de HAL,

- la base de données géographique Geonames,

- le thésaurus PACTOLS spécialisé en archéologie et sciences de l’Antiquité,

- le répertoire d’autorités RAMEAU…

Lorsque chaque notice est récupérée par Isidore, elle est enrichie grâce à ces différentes sources. Donc, lorsqu’on fait une recherche via Isidore, les notices récupérées présentent plus d’informations que dans leur base de données source : une indexation plus riche, des données de géolocalisation, d’autres notices liées…

Des informations facilement récupérables

C’est déjà beaucoup, mais il y a encore mieux : Isidore expose ses données, il permet aux utilisateurs de les récupérer pour les ré-exploiter ensuite dans d’autres environnements.

Un des points d’accès proposé pour cela est l’API web d’Isidore : derrière ce sigle un peu mystérieux que l’on traduit en français par « interface de programmation« , on parle en fait d’un service par lequel un logiciel, un fournisseur expose tout ou partie de ses données et/ou de ses fonctionnalités.

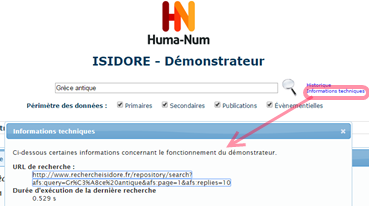

Revenons donc à Isidore : l’API est documentée sur ce site, on peut y effectuer une recherche classique par un formulaire de recherche. La recherche fournit une liste de résultats web (format HTML normal), mais en cliquant sur « Informations techniques », on obtient un lien vers les mêmes résultats, mais en XML.

Ce format est :

- structuré (il distingue les titres, les auteurs, les dates, etc.)

- enrichi (pour un auteur donné, il renvoie vers différentes sources où cet auteur est référencé ; il rajoute diverses indexations)

- interopérable (on peut récupérer ce fichier XML pour le « manipuler » à d’autres fins)

Bon, c’est là que ça se complique un peu car ces notices en XML, on n’en fait rien en tant que telles : il faut savoir les manipuler avec des langages comme XSLT ou PHP pour les exploiter, les convertir sous d’autres formats, bref les redistribuer.

Cas pratique

Mais assez de blablas, un bon exemple valant mieux que de longs discours, Imaginons que je commence une thèse sur le concept de culotte comme indicateur sociétal en France.

Je souhaite donc commencer par faire une cartographie de l’ensemble des publications francophones sur la culotte sous ses dimensions historiques, sociales, linguistiques etc… Pour cela j’ai donc besoin de constituer un corpus de références de publications (une bibliographie du sujet) que je pourrai ensuite analyser en le soumettant à d’autres logiciels d’exploration et de visualisation.

J’interroge donc l’API d’Isidore en utilisant le mot-clé « Culotte » soit « http://www.rechercheisidore.fr/repository/search?afs:query=Culotte&afs:page=1&afs:replies=100 » (les derniers paramètres indiquant que j’affiche d’abord la page 1 de la liste de résultats et que je souhaite afficher 100 résultats par page). En interrogeant l’API de manière récursive sur toutes les pages de résultats, j’obtiens en réponse 836 notices, que je peux donc manipuler (si je parle le XSLT, ou si je demande à ma BU qui le connaît), transformer en XML, CSV, JSON, ou tout autre format et ensuite analyser comme je le souhaite.

Ainsi, en passant par l’API Isidore (plutôt que la recherche standard), je peux pour chaque notice obtenir le lieu de publication de la ressource décrite, et sa discipline. Je peux ainsi confronter répartition géographique et disciplinaire des publications moissonnées :

Publications scientifiques sur la « culotte » : répartition géographique et disciplinaire – visualisation obtenue avec le logiciel Tableau Public

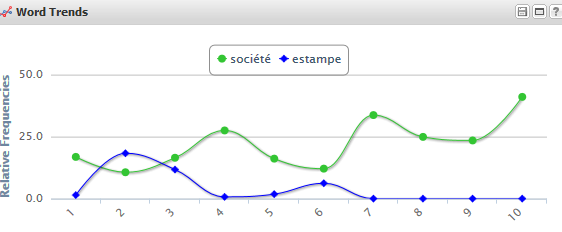

Ou encore visualiser sous forme de graphe les relations de proximité entre concepts :

Concepts associés à chaque notice et liens entre eux – visualisation obtenue avec le logiciel Voyant Tool

Ou encore extraire les résumés dans l’ordre chronologique et en étudier les fréquences d’apparition de certains mots :

Fréquence de certains mots-clés dans les 836 ressources traitant de la culotte – visualisation obtenue avec Voyant Tool

Fréquence de certains mots-clés dans les 836 ressources traitant de la culotte – visualisation obtenue avec Voyant Tool

Ou encore etc…

A partir du même exemple, vous pouvez visualiser sur cette page web d’autres types d’exploitation de données récupérées grâce à l’API d’Isidore, véritable sésame pour l’exploration de corpus bibliographiques en SHS.

Logiciels libres utilisés : Tableau Public, Voyant Tools, Simile Exhibit.

NB : les données aspirées par l’API l’ont été uniquement pour l’exemple, elles n’ont pas été nettoyées de toutes leurs « scories » éventuelles, ce qui explique un affichage pas toujours très « propre ».

A suivre

Dans un prochain billet : le Sparql Endpoint d’Isidore, un autre point d’accès pour explorer sémantiquement les données d’Isidore structurées en RDF.