Articles taggés valorisation des collections

Périodiques remarquables : Les procédés modernes d’illustration et les industries qui s’y rattachent

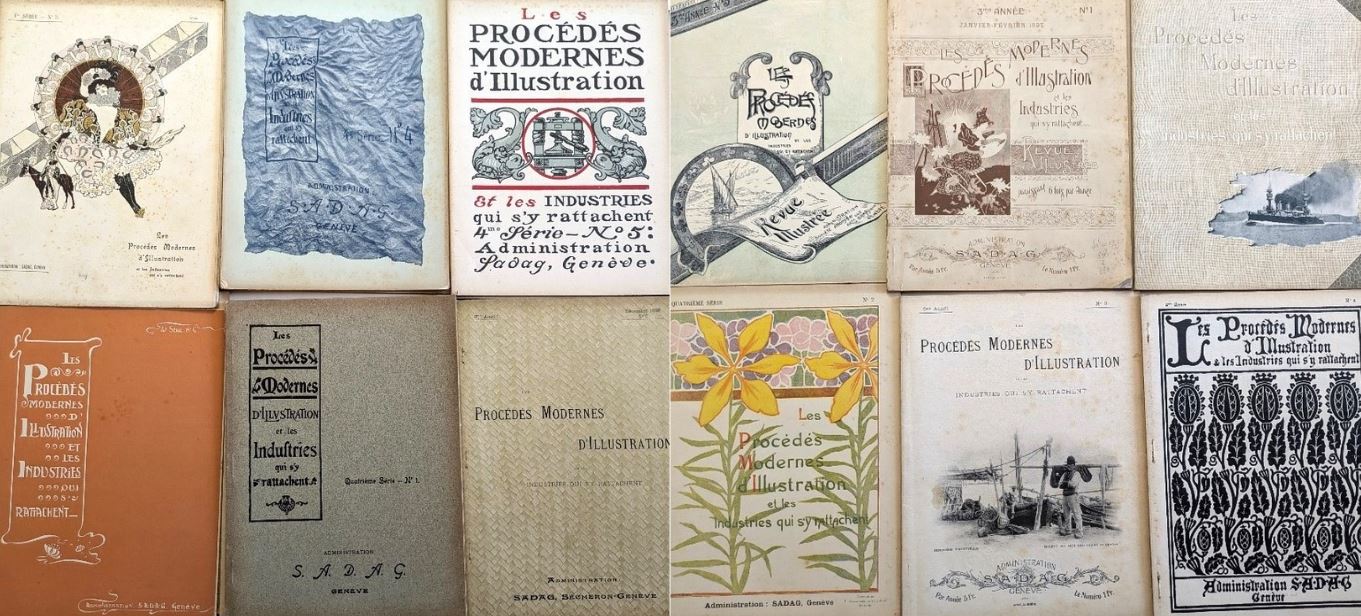

Lors de la révision des inventaires de la bibliothèque du Chevalier de Cessole, nous avons trouvé dans un tiroir des numéros de la revue Les Procédés Modernes d’Illustration et les Industries qui s’y rattachent, en excellent état. Certains numéros n’avaient jamais été ouverts, des pages étaient encore scellées avec des coupons d’abonnement à l’intérieur.

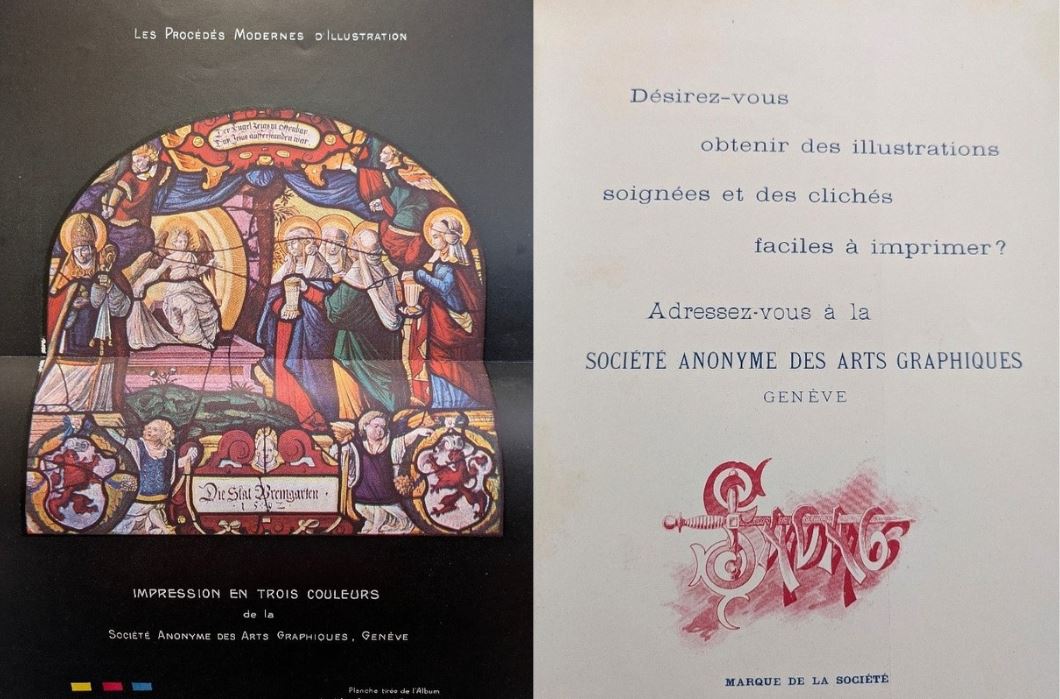

Cette revue professionnelle est produite par la SADAG (Société Anonymes Des Arts Graphiques), une entreprise suisse créée par l’alpiniste et photographe Frédéric Thévoz et son ami Louis Chauffat. À la pointe des techniques de procédés d’impression photomécaniques, la SADAG a eu, au pic de son activité, trois grandes usines à travers l’Europe. Elle produisait des catalogues et des affiches pour les musées d’Europe, des menus pour les grands restaurants, et imprimait des illustrations pour des monographies et des périodiques.

Stoppée dans les années 1930 avec la crise économique, elle multiplie les fusions, réduit son activité et existe encore aujourd’hui sous le nom d’Atar Roto Presse. Elle publie depuis 2000 le journal Le Courrier.

La revue rend compte des dernières avancées techniques et des productions de l’entreprise, à destination de clients potentiels ou fidèles. Jusqu’à sa cinquième année de parution, les couvertures changent à chaque numéro avec un style esthétique très différent, pouvant aller de la reproduction d’aquarelle à un effet « papier froissé » tout à fait bluffant. Nous pouvons trouver à l’intérieur des numéros des exploits techniques, comme cette double page avec une reproduction fidèle d’un vitrail d’église.

Vous pouvez consulter cette revue à la bibliothèque du Chevalier de Cessole.

Membres du réseau, n’hésitez pas à faire part de vos périodiques remarquables pour que nous les mettions en avant : écrivez-nous à sudoc-ps.paca-nice@univ-cotedazur.fr.

Trois revues d’art niçoises, périodiques remarquables de notre réseau

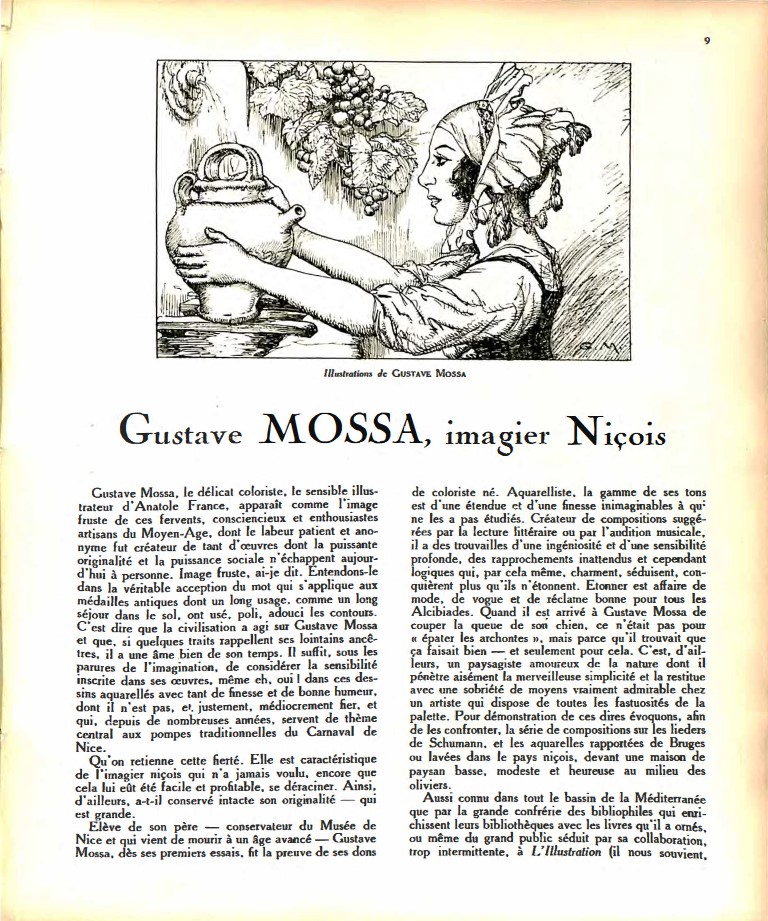

Dans ce billet nous présentons 3 revues d’art éditées à Nice. Ce type de publication reproduit et assemble des créations artistiques, inédites ou reproduites, et sert de médiation entre artistes, et entre les artistes et le public. Il permet de créer du discours sur la culture et sa diffusion, et sur l’art en lui-même. Les revues choisies ici ont été publiées à 3 périodes différentes, et constituent un reflet des capacités éditrices de leur époque et des différents publics qu’elles visent.

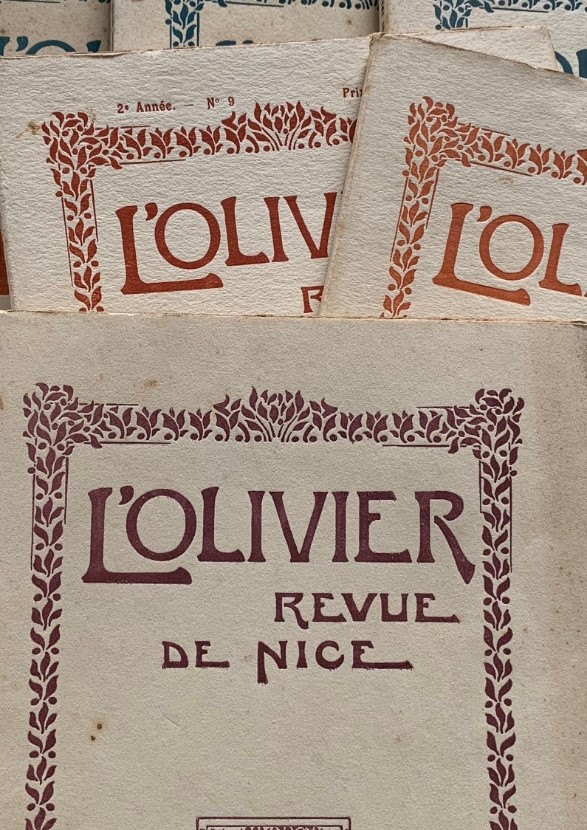

La première revue est L’Olivier, publiée entre 1912 et 1914. Il s’agit d’une publication indépendante de 10 numéros par année contenant des poèmes, des critiques d’art et des publications inédites de correspondances entre artistes. Bien qu’ayant une publication courte, l’équipe de L’Olivier s’est donné les moyens de produire pour chaque numéro 25 exemplaires spéciaux imprimés sur papier Japon, plus coûteux, plus épais, mais aussi pour notre intérêt plus faciles à conserver. L’objectif était d’en faire un bel objet, dans la mesure de leurs moyens et avec la limitation d’une impression exclusivement textuelle. Comme dans la majorité des revues d’art, la rédaction est composée d’artistes, comme l’auteur Bernard Barbery ou le peintre Paul Audra, mais également de personnes impliquées dans la politique culturelle locale comme Joseph Levrot qui fut rédacteur en chef de Nice Historique de 1909 à 1914 et ayant travaillé au sein des bibliothèques et des archives de la ville de Nice. L’Olivier est aujourd’hui conservé dans un grand nombre d’établissements (dont 6 du réseau PACA/Nice) et un numéro est consultable sur Gallica.

La deuxième revue présentée a fait l’objet d’un article dans Les Cahiers de la Méditerranée par notre collègue Dominique Laredo. Il s’agit de Méditerranéa, publiée de 1927 à 1940. Une revue qui a eu pour objectif de légitimer une culture méditerranéenne en promouvant les artistes locaux, mais également en se faisant le relais d’expositions à travers le monde par des reproductions d’œuvres. On y retrouve, en plus des reproductions citées, des textes inédits mais également des illustrations originales qui en font un objet de grande valeur. Son impression de qualité (bien que monochromatique) lui a permis de se bâtir une solide réputation et avoir la reconnaissance et l’appui de certains députés. Il parait évident que cette revue initiée par Paul François Castéla, qui n’en était pas à son coup d’essai, a créé une certaine effervescence, un mouvement qui coexista avec la création du Centre Universitaire Méditerranéen inauguré en 1933. Au vu de son intérêt, elle est conservée dans un grand nombre d’établissements (dont 5 du réseau PACA/Nice), et elle a également pu bénéficier d’une grande opération de numérisation à la BMVR de Nice, qui nous a été présentée pendant la journée professionnelle du Sudoc-PS de 2019, elle est consultable sur la plateforme patrimoniale NICEA. Certains numéros sont également sur Gallica et un numéro spécial dans les Fonds Anciens de Grasse.

La dernière revue est un objet particulier. Là où les deux précédentes revues voulaient se rendre légitimes et donc avaient un certain standard d’édition, Evidence est un périodique qui se rapproche plus du fanzinat, artisanal dans sa conception. Avec son arrangement à base de collages accompagnés de dessins d’artistes et de poèmes, avec en son cœur un mini-magazine à plier soi-même dans chaque numéro. Son esthétique punk a une origine évidente : il est édité par Bramstocker Association, fondée par les membres du groupe punk niçois Bramstocker, composé originellement de Fréderic Vidal (le rédacteur en chef), Jean-Paul Albert, Christian Leblond, Jean-Luc Zerbib et Patrick Douillon. Evidence a pour vocation de parler à la jeunesse de Nice (tirages importants à bas prix) pour promouvoir l’activité culturelle locale et porter également des revendications de démocratisation de la culture. Publié uniquement de 1981 à 1982, ce périodique est conservé dans 3 établissements du réseau et ne possède pas encore de version numérisée.

N’hésitez pas à aller consulter ces titres dans les établissements du réseau les possédant ou bien à accéder à leur numérisation. Chaque type de périodique a son histoire, ses variations, et peut inspirer aux lecteurs une curiosité ou des idées de recherches dans leurs domaines scientifiques. Evidence met d’ailleurs en avant l’idée d’Initiative Culturelle : l’accès à la culture est nécessaire pour que d’autres s’en saisissent et la fassent vivre.

L’Exprimante, déjà 2 ans d’utilisation

Souvenez-vous, il y a deux ans nous vous présentions L’Exprimante, le distributeur de presse ancienne créé par l’Agence Auvergne-Rhône-Alpes Livre et Lecture, qui utilise la base documentaire de Lectura +.

Depuis cet outil de médiation a circulé dans différents établissements de la région Auvergne-Rhône-Alpes. L’Agence Auvergne-Rhône-Alpes Livre et Lecture a profité de son rendez-vous numérique mensuel « Le 11/12 » de décembre 2023 pour inviter Guénaël Borg (responsable du fonds Auvergne de la Bibliothèque du patrimoine de la métropole Clermont Auvergne), et Myriam Ikhlef (technicienne formation, recherche, documentation, à l’Établissement public local d’enseignement et de formation professionnelle agricole de Cibeins) afin de faire un retour d’expérience du passage de l’Exprimante au sein de leurs établissements.

Au Lycée agricole de Cibeins à Mizérieux, les élèves ont pu découvrir l’Exprimante avec curiosité avec un atelier d’Éducation aux médias et à l’information sur le thème « 100 ans de faits divers » où ils ont pu comparer en groupes la différence de traitements de faits similaires dans le passé et aujourd’hui.

À la Bibliothèque du Patrimoine de la métropole Clermont Auvergne c’est autour d’un atelier sur le thème « Comprendre l’évolution de la presse d’actualité depuis 150 ans à travers ses impacts sur la société » que les lecteurs ont pu se familiariser avec cet outil, et l’adopter au point de venir obtenir leur sélection quotidienne d’articles si souvent que la Bibliothèque a dû se fournir en rouleaux à papier pour recharger la machine (pourtant prêtée par l’Agence pour une durée de 2 à 4 mois avec 5 rouleaux fournis !).

Les ressources de ces ateliers sont à retrouver en libre accès sur Lectura +, qui propose des fiches méthodologiques pour mettre en place des actions culturelles autour du patrimoine écrit.

L’Exprimante est un outil très modulable : pas besoin de grandes compétences informatiques pour changer les articles et images présents dans la machine ou modifier certains paramètres d’impression. L’équipe de la médiathèque Jean-Jacques Rousseau, dans le cadre de leur exposition « Pop’ : un siècle de littératures & lectures populaires », a préparé une sélection personnalisée de récits courts, poèmes et feuilletons présents dans les titres disponibles sur Lectura +.

Une expérience qui rappelle les distributeurs éphémères d’histoires courtes installés par la SNCF dans les grandes gares de France en 2016 et ayant marqué le public, pour certains, non lecteurs, ayant pris le temps de lire quelques minutes un texte inattendu.

L’Exprimante est un outil stimulant qui valorise un patrimoine écrit et visuel et qui permet une approche ludique de la lecture à travers une consommation courte, ponctuelle et immédiate. Elle produit aussi un souvenir matériel que l’on peut conserver et qui peut devenir un objet de discussion. C’est un outil qui gagnerait à se développer. Les retours ont montré que la machine remplit tous les objectifs fixés au début du projet.

Si l’Exprimante est disponible à l’emprunt uniquement pour des établissements de la région Auvergne-Rhône-Alpes, l’entièreté des plans, listes de composants et programmes pour la fabriquer sont disponibles sur le site de Lectura + sous licence Creative Commons CC BY-NC-SA. Peu onéreuse, il ne tient qu’aux collectivités de construire leur propre machine pour mettre en valeur leur patrimoine ou l’utiliser à des fins de médiation diverses, tant l’outil est modulable.

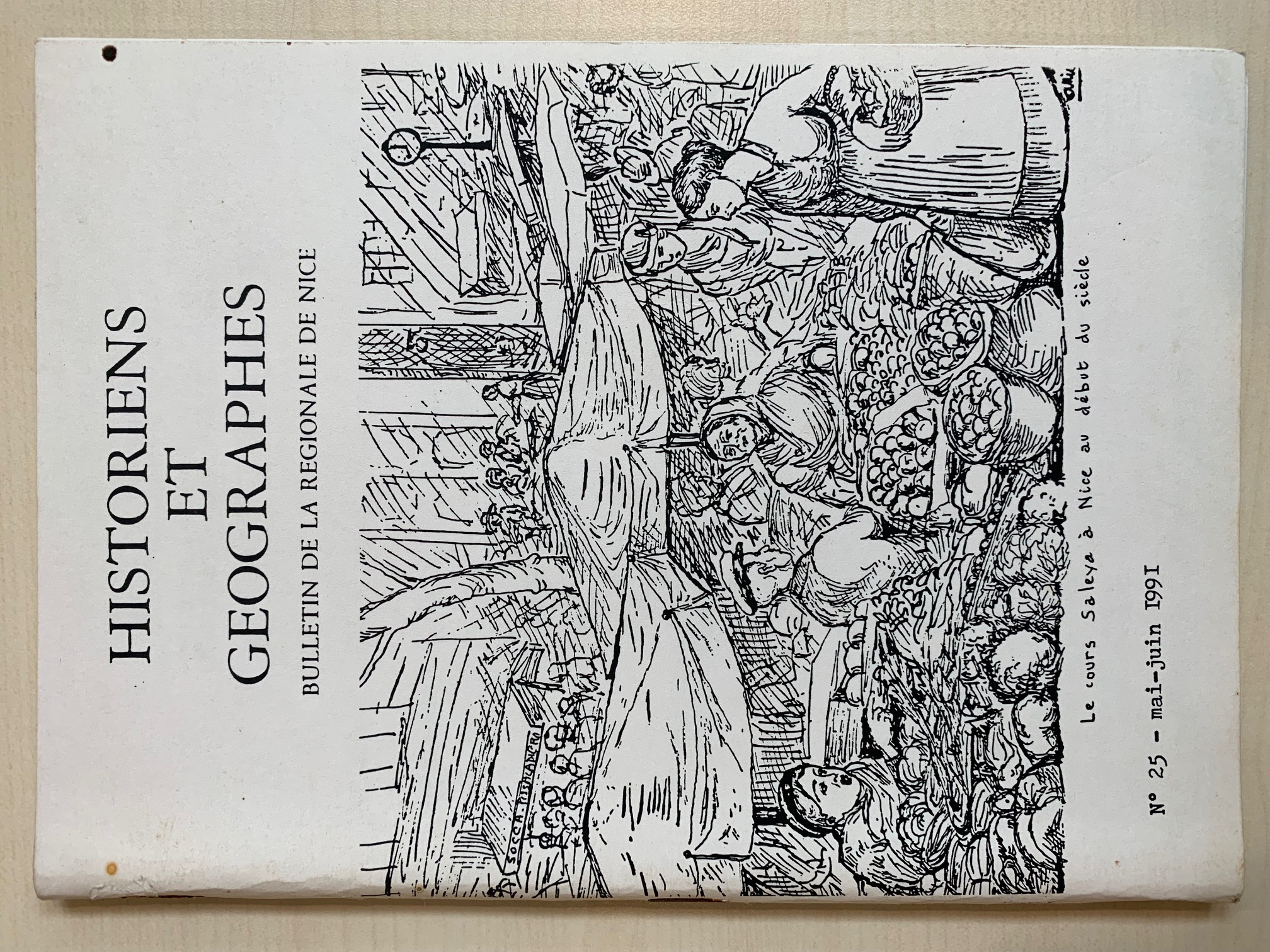

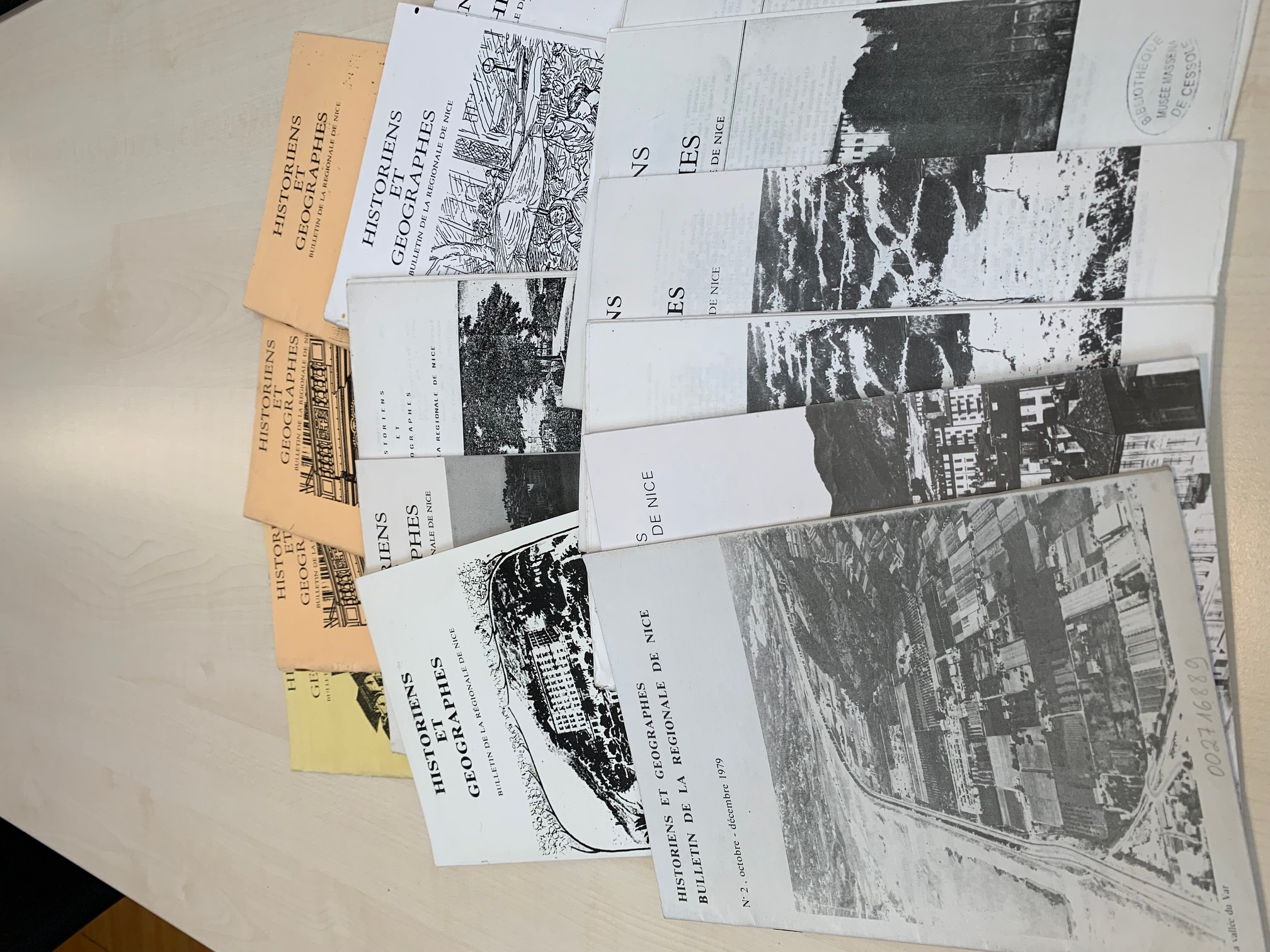

Périodiques remarquables de notre réseau : Historiens et Géographes – Bulletin de la Régionale de Nice

Nous débutons sur notre blog une nouvelle série de billets participatifs dans lesquels les établissements de notre réseau choisiront de mettre en avant des périodiques rares ou remarquables (périodiques localisés dans peu d’établissements) ou des unicas (périodiques localisés dans un unique établissement). Aussi, cher·e·s collègues des établissements du réseau, n’hésitez pas à nous suggérer par mail (sudoc-ps.paca-nice@univ-cotedazur.fr) les périodiques rares de vos collections que vous souhaiteriez mettre en avant de manière similaire sur notre blog.

La Bibliothèque du Chevalier de Cessole, située au dernier étage du Palais Masséna, a eu récemment un don conséquent de périodiques de la part de Jean-Philippe Fighiera, professeur de nissart et historien local. Au sein de ce don se trouvait une collection importante des numéros de la revue sujet de notre billet : Historiens et Géographes – Bulletin de la Régionale de Nice.

Si la revue nationale Historiens et Géographes publié par l’APHG (Association des Professeurs d’Histoire et de Géographie), encore en cours de parution, est assez populaire et bien conservée, peu connaissent aujourd’hui l’édition locale produite par la Régionale de Nice de l’APHG conservée actuellement dans 3 établissements de manière conséquente : les Archives Départementales des Alpes-Maritimes [n°1 (1979) – n°43 (2007) ; n°30 (1994) et n°42 (2006) manquants. Conserve aussi le supplément Dossier pédagogique « Monaco » n°1 (1997)], la Bibliothèque universitaire Henri Bosco (Campus Carlone) [n°1 (1979) – n°22 (1989) ; n°27 (1993) – n°28 (1993)], et maintenant la Bibliothèque du Chevalier de Cessole [n°2 (1979) – n°25 (1991) ; n°4, 14-15, 17-24 manquants].

Ralph Schor, professeur émérite d’histoire contemporaine à Université Côte d’Azur et président de la Régionale de Nice de l’APHG pendant 30 ans, était également le directeur de la revue. Il nous a confié :

« Le bulletin académique que vous connaissez fut créé comme un supplément de la revue nationale. L’objectif était de fournir aux collègues des informations pratiques, des articles de fond en relation avec les programmes, des comptes rendus d’ouvrages parus ou de voyages d’études organisés par la Régionale. Il s’agissait en somme d’une sorte de formation continue »

Ralph Schor écrivait également dans l’un des éditos de la revue :

« Nous réclamons toujours le bénéfice de la formation continue. Des professeurs se plaignent d’être isolés, dépourvus de soutien pédagogique et confrontés à des programmes dont l’enseignement est difficile. (…) La Régionale de Nice participe à cet effort général. Dans la mesure de ses moyens, elle aide les collègues de l’Académie. »

Il y avait une réelle volonté, en plus de cette mission de formation continue, de permettre aux professeurs des collèges et lycées de garder un contact avec l’activité des professeurs universitaires et de l’avancée de la Recherche. Également, cette revue représentait l’opportunité de mettre en avant les publications rédigées par des enseignants du secondaire. Ralph Schor nous confiait :

« Les auteurs étaient tous, ou presque, des professeurs du second degré ou du supérieur en poste dans l’académie de Nice. »

Concernant la fabrication de la revue :

« Je me chargeais de la mise en forme. Cette publication représentait une charge assez lourde. Heureusement je la faisais imprimer à la Faculté des Lettres qui facturait le travail au prix coûtant. Charles Ehrmann, doyen de l’Assemblée nationale et élu départemental, se souvenant de ce qu’il avait été professeur d’histoire et géographie, nous fit longtemps attribuer une petite subvention par le Conseil général. »

Cette revue précieuse est en cours de dépouillement à la Bibliothèque de Cessole et vous pouvez surveiller le catalogue de la BMVR de Nice pour plus d’informations.

Le Conservatoire national de la presse d’Amiens

Photo Milner Moshe, GPO. http://www.flickr.com/people/69061470@N05 [CC BY-SA 3.0, via Wikimedia Commons]

Le nouveau Pôle de conservation de la Bibliothèque nationale de France a été évoqué notamment lors des Journées du patrimoine écrit à Rouen en juin dernier. Faisons le point sur la double mission de ce projet ambitieux qui devrait ouvrir ses portes en 2028, prochainement en construction à Amiens pour un coût entre 70 et 90 millions d’euros.

Le nouveau pôle de la BnF regroupant Conservatoire national de la Presse et centre de conservation pour ses collections répond aux problématiques de saturation des espaces au sein des bâtiments existants de la BnF, avec notamment la création de magasins de collections hautement technologiques, indispensables à la préservation des documents les plus fragiles, et particulièrement à la collection de presse qui sera au cœur du projet. Il devrait permettre d’accélérer la numérisation de ces fonds majeurs et de faciliter leur consultation et leur rayonnement.

Le projet d’Amiens Métropole a été choisi parmi 72 candidatures pour ses atouts géographiques et la cohérence du projet : soutien logistique et financier de la Métropole pour la construction, aide à l’installation pour les personnels de la BnF, etc. Par ailleurs, il intègre une proposition culturelle ambitieuse s’articulant autour de la création d’un Centre d’Interprétation de la Presse, en lien avec le réseau des Bibliothèques d’Amiens Métropole, et de la promotion de la filière « Arts visuels », dans une approche transversale et originale de la valorisation de la presse écrite.

Nous ne manquerons pas de vous tenir au courant de l’avancée de ce projet majeur pour la conservation et la valorisation de la presse.

Les Journées du Patrimoine Écrit 2022 (Rouen)

Les Journées du Patrimoine Écrit se sont tenues cette année à Rouen les 23 et 24 juin.

Retrouvez ici l’enregistrement de la journée du 23 juin, plus particulièrement consacrée à des thématiques liées aux périodiques.

Les thèmes abordés au cours de cette journée :

– le site Presse Locale Ancienne (début de la vidéo),

– le réseau Sudoc-PS et l’outil Périscope (0:14:30),

– les nouveaux partenariats et circuits de signalement des périodiques (0:29:30),

– coordination des programmes de numérisation de corpus de presse, les projets de coordination de type Plans de conservation partagée (2:45:00)

– présentation du futur Pôle de conservation de la BnF à Amiens : centre de conservation et Conservatoire National de la Presse (4:46:56)

La journée du 24 juin a été l’occasion d’évoquer des fonds littéraires conservés dans des bibliothèques normandes, ainsi que des thématiques de conservation. Vous retrouverez dans l’enregistrement vidéo de la journée :

– 2 interventions autour de la valorisation du patrimoine littéraire : musées et littérature, comment exposer la littérature (0:11:00) ; valoriser les archives littéraires (01:56:00)

– les plans d’urgence en bibliothèque : sauvegarde des collections, conditions de conservation, réagir en cas de sinistre (4:38:50)

La presse ancienne à l’honneur à Rouen

Nous attirons l’attention des membres du réseau sur les conférences des Journées du patrimoine écrit 2022 qui se tiendront les 23 et 24 juin à Rouen. Elles seront retransmises en ligne sur la chaîne YouTube de Normandie Livre & Lecture, Agence de coopération des métiers du livre en Normandie (où elles seront probablement visibles également ultérieurement).

En effet la journée du jeudi 23 juin, Numériser, valoriser et conserver la presse ancienne, entre en résonance avec les différentes thématiques que nous avons abordé ces dernières années autour de la presse locale ancienne.

Nous vous invitons à suivre notamment :

♦ 11h – 12h30 : Les enjeux juridiques et le signalement de la presse ancienne : des préalables indispensables à la numérisation

⇒ Le cadre juridique régissant la numérisation de la presse, exposé par David Pouchard, adjoint à la cheffe du bureau de la propriété intellectuelle (Service des affaires juridiques et internationales, ministère de la Culture)

⇒ Table ronde sur le signalement de la presse (enjeux autour du catalogue collectif national des publications en série SUDOC PS ; le portail « Presse locale ancienne »)

♦ 14 h – 16h : Numériser les collections de presse : comment coordonner les différents programmes nationaux et locaux ?

⇒ Table ronde sur la coordination des programmes de numérisation nationaux et locaux et la diffusion numérique de la presse ancienne

♦ 16 h – 17h30 : Quel avenir pour la conservation physique des collections de presse ?

⇒ Table ronde sur le projet de centre de conservation de la BnF à Amiens et les plans de conservation partagée

Retrouvez le programme détaillé des 2 journées ici : https://www.eventbrite.fr/e/billets-journees-du-patrimoine-ecrit-2022-319314828247

Application Unicas / Presse locale ancienne : grosse actu ! (5/5)

Car il faut bien l’avouer, depuis sa présentation lors de la 7ème journée annuelle du réseau et sa mise en production dans la foulée, l’application était un peu restée « dans son jus » : pas totalement finalisée dans sa partie documentation, soumise à quelques bugs techniques sur les visualisations en graphe, un code source indisponible etc…

Cela ne nous a pas empêché de l’utiliser, comme prévu, en tant que base de travail pour l’amélioration de la qualité des métadonnées durant les 4 derniers mois de 2020 (comme décrit dans ce précédent billet), mais une petite remise à niveau s’imposait tout de même.

Outre les améliorations portant sur l’architecture de l’application elle-même, l’interface web présente elle aussi quelques mises à jour ayant pour but d’améliorer l’expérience des utilisateurs :

- sur les vues spécifiques dédiées aux unicas et aux titres de presse locale ancienne, les métadonnées se présentent désormais sous forme de tableaux web avec les principales fonctionnalités nécessaires à leur manipulation : des tris par colonne en cliquant leurs entêtes, des filtres par colonne sur la base d’opérateurs textuels ou par valeurs uniques, un moteur de recherche global tous champs, une fonctionnalité de regroupement par ligne (donc notice) selon un critère commun, la possibilité d’export Excel etc…

- le changement de librairie graphique pour les visualisations en réseau a permis de stabiliser la page dédiée et d’améliorer la lisibilité des graphes produits, permettant au passage d’afficher des vues intéressantes sur les collections du CR, par exemple cette visualisation des localisations de titres de presse locale conservés (et souvent co-conservés sur plusieurs bibliothèques).

- Côté documentation enfin, notamment pour expliciter les modalités de redistribution par API des données stockées dans la base de données en graphe et faciliter leur éventuelle réutilisation dans d’autres contextes ou applications, cette nouvelle page a été ajoutée, qui décrit la structures et fonctions de l’API selon un standard Open source très largement connu et utilisé par les développeurs.

Concernant le code de l’application proprement dit, sa mise à disposition en open source était une spécification incontournable pour nous dès le début, à la fois par philosophie et pour tous les avantages induits par l’ouverture des codes (relecture, processus collectif d’amélioration, réutilisations… ). L’Abes s’étant de son côté lancé depuis plusieurs mois dans une politique de développement (au sens informatique du terme) centrée entre autres sur la mise en open source de leurs codes et l’impulsion d’une dynamique de co-construction avec les membres du réseau Sudoc, il nous est donc apparu naturel de libérer le code source de l’application en le déposant sur l’espace Github de l’Abes, le rendant accessible dans une version documentée ici : https://github.com/abes-esr/sudocps-graph-app. En accord avec l’Abes, nous avons d’ailleurs accompagné ce dépôt par la publication d’un billet sur Punktokomo, le blog technique créé et maintenu par l’Abes.

Enfin, en bonne place parmi les objectifs nous ayant guidé(e)s pour la réalisation et le développement de l’application, et en corollaire du point précédent, se trouve également la possibilité pour les autres Centres du réseau Sudoc-PS de reprendre à leur compte autant le workflow d’alimentation de la base de données que le code informatique de l’application, afin de pouvoir relativement facilement déployer leur propre version basée sur les données de leur périmètre. Et effectivement, le CR voisin PACA/AIx-Marseille, emmené par notre collègue du SCD de l’AMU Axelle Clarisse, nous a récemment contacté en ce sens, aboutissant dans une première étape à la mise en ligne d’un prototype exploitant les unicas et les titres de presse locale du CR Sudoc-PS marseillais, utile de leur côté afin d’avoir un premier aperçu de leurs données sans avoir à se lancer dans une procédure d’installation en dur, et indispensable pour nous afin de nous permettre de vérifier et ajuster la reproductibilité du dispositif.

Et puis dans la région PACA, Nice et Marseille qui collaborent, c’est assez remarquable pour être remarqué !

L’Exprimante, le distributeur de presse ancienne

Vous cherchez des idées nouvelles pour mettre en valeur vos collections et intriguer de nouveaux publics ? L’Exprimante est peut-être pour vous !

Il s’agit d’un distributeur qui délivre sous forme de tickets, de manière aléatoire, des articles parus dans l’un des 60 titres numérisés disponibles sur Lectura Plus (portail du patrimoine écrit et graphique en Auvergne-Rhône-Alpes) et publiés de 1807 à 1945 : du fait divers à la petite annonce, en passant par la vie politique, les loisirs, et la publicité, c’est l’occasion d’ouvrir une petite fenêtre éphémère sur le quotidien de l’époque.

Un court teaser est disponible sur YouTube pour présenter ce distributeur ludique et interactif.

Le dispositif peut intéresser des établissements accueillant des publics très divers. Si comme nous vous êtes intrigué·e par cette nouvelle machine, rendez-vous le 11 mai 2021 de 14h à 16h30 pour une rencontre professionnelle De la presse ancienne à l’éducation aux médias, accessible en ligne, et durant laquelle l’Exprimante sera présentée en détail. Programme et inscription gratuite ici.

Sachez que les plans de fabrication, la liste du matériel nécessaire ainsi que le code informatique seront prochainement accessibles (en licence Creative Commons CC BY-NC-SA) pour permettre à tout établissement qui le souhaite de fabriquer, avec un FabLab par exemple, son propre distributeur (disponible ici après la présentation du 11 mai).

On en profite pour découvrir le magnifique portail Lectura Plus, créé en 2017 pour mettre en valeur les collections numérisées en Auvergne-Rhône-Alpes. Très riche et documenté, il donne accès à des fonds patrimoniaux, de la presse ancienne, des collections de photographies, mais aussi du patrimoine sonore (légendes et récits, chants traditionnels).

Joconde : les collections d’objets des musées français révélées

Dans un billet précédent nous avions évoqué l’existence de la base nationale Joconde. Nous avons souhaité lui consacrer un billet de présentation spécifique étant donné son intérêt et sa richesse.

Joconde est le catalogue collectif des collections des musées de France, librement accessible sur internet. On y trouve à ce jour environ 600 000 notices d’objets, le plus souvent illustrées par une ou plusieurs images. Ces notices proviennent de près de 300 musées français qui les enrichissent et les actualisent en permanence.

Les objets décrits proviennent de collections d’archéologie, beaux-arts, arts décoratifs, ethnologie (européenne et extra-européenne), histoire, ou encore sciences et techniques. Les objets sont de nature très diverse : sculptures, outils, peintures, objets, dessins, céramiques, estampes, costumes…

Plusieurs modes de recherche sont proposés :

* la recherche simple : de type « moteur de recherche », en tapant un mot ou un groupe de mots. Les résultats peuvent être affinés par des facettes.

* la recherche par listes : en cliquant sur le terme qui vous intéresse au sein d’une liste alphabétique.

* la recherche avancée : permet de combiner plusieurs critères de recherche (auteur, domaine, date de création, lieu de conservation…)

Des parcours thématiques, des zooms et des expositions virtuelles complètent les modes de valorisation des collections.

A noter également : une section Espace professionnel qui, comme son nom l’indique, regroupe une documentation autour de questions purement professionnelles telles que la description des objets à l’aide d’un thésaurus, la numérisation des collections, l’informatisation d’un inventaire ou d’un récolement, etc.

Depuis 2019 Joconde verse ses notices dans POP (Plateforme ouverte du patrimoine), vaste recensement du patrimoine français sous toutes ses formes, alimentée par différentes bases. Ainsi, c’est désormais l’interface de recherche de POP qui est utilisée pour les modes de recherche Simple et Avancée.